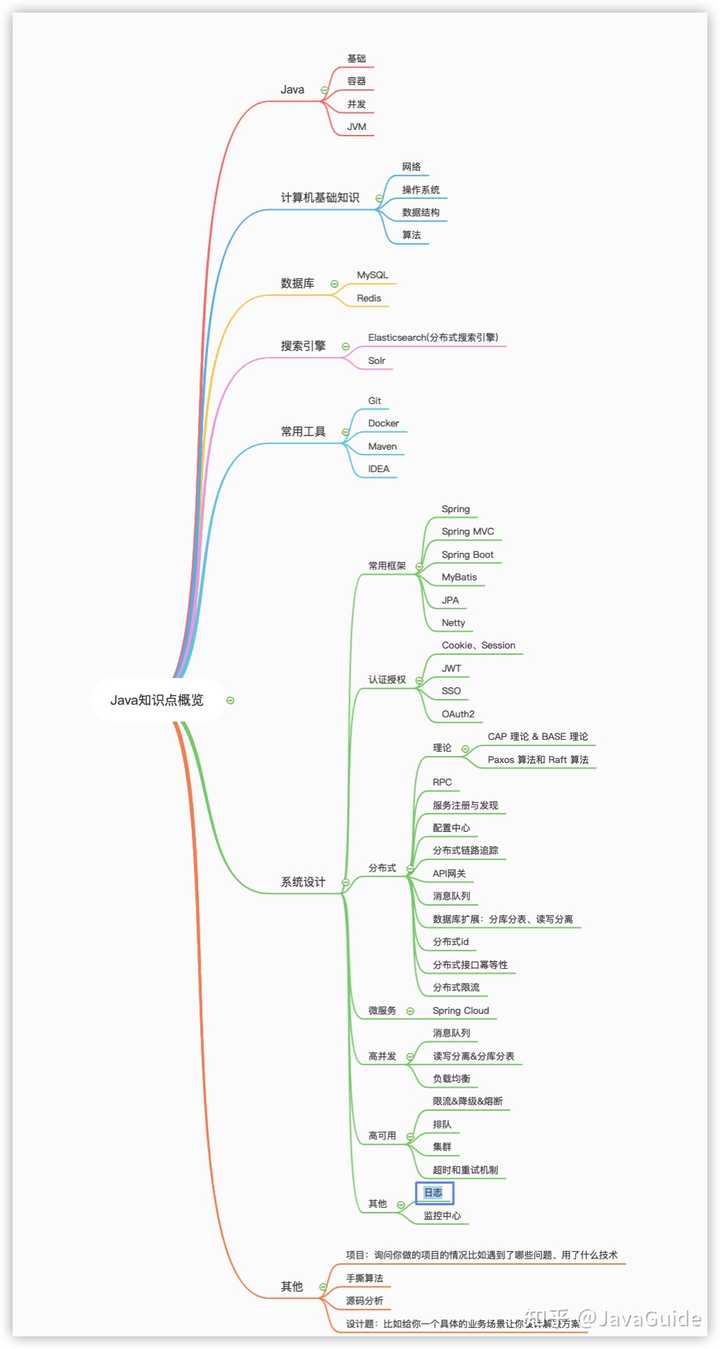

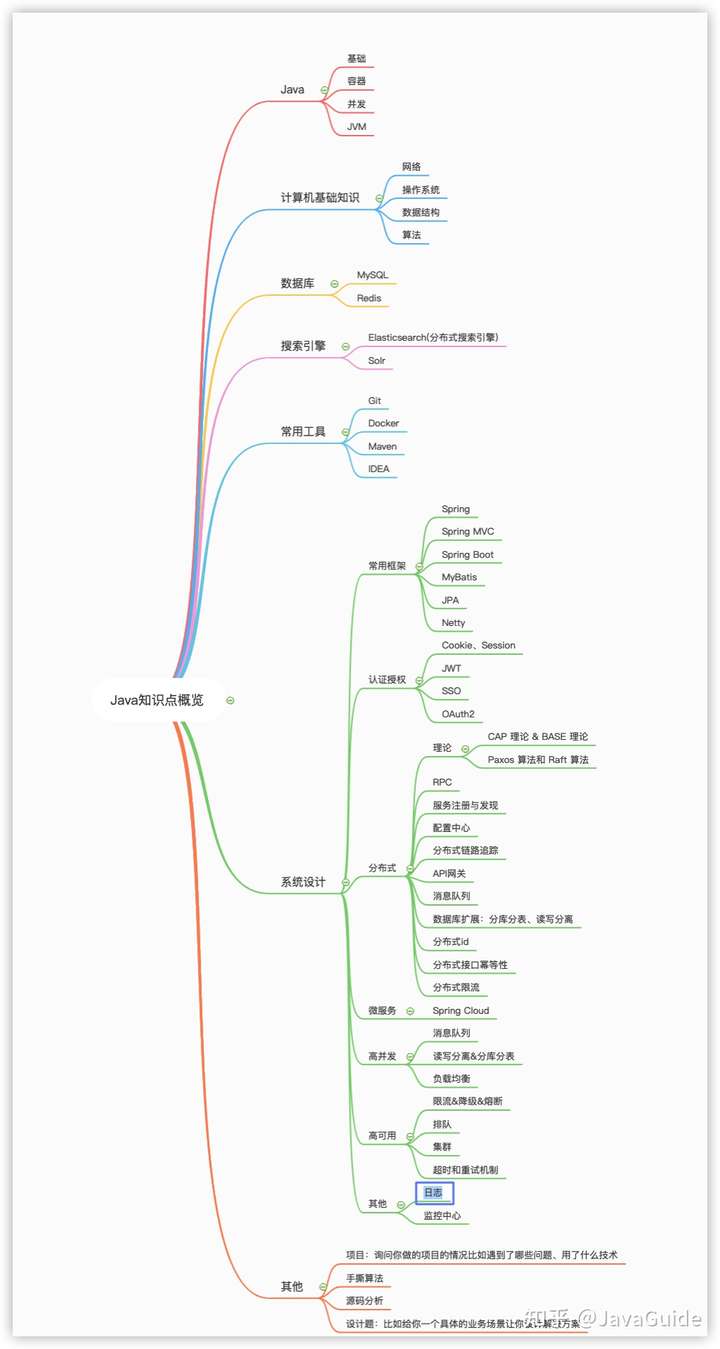

java学习路线问题整理

Java 基础

为了能让自己写出更优秀的代码,《Effective Java》、《重构》 这两本书没事也可以看

并发

一些关于并发的小问题,拿来自测:

一、什么是线程和进程? 线程与进程的关系,区别及优缺点?

**Linux****的进程、线程、文件描述符是 什么

**答案:在 Linux 系统中,进程和线程几乎没有区别。

Linux 中的进程就是一个数据结构,看明白就可以理解文件描述符、重定 向、管道命令的底层工作原理,最后我们从操作系统的角度看看为什么说线 程和进程基本没有区别。

1、进程是什么

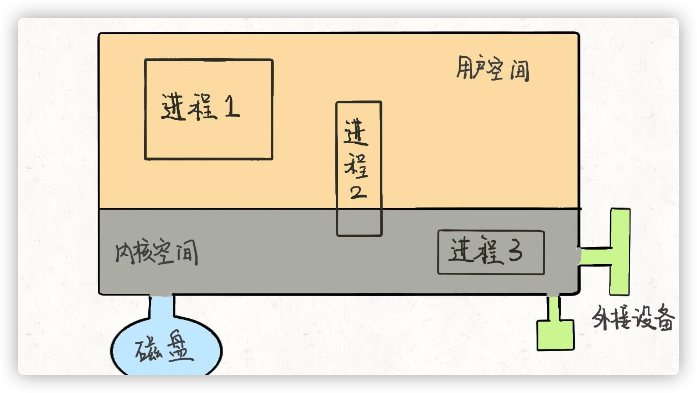

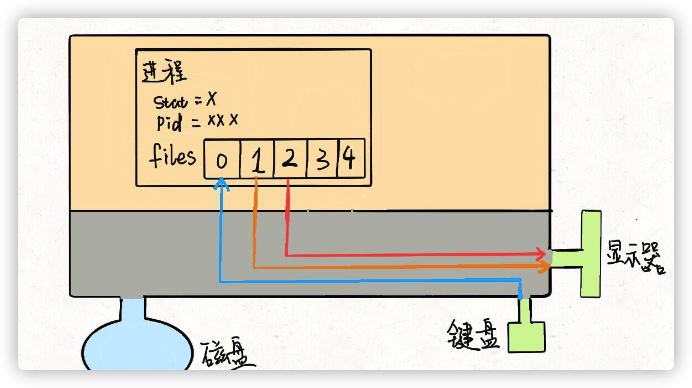

首先,抽象地来说,我们的计算机就是这个东⻄:

这个大的矩形表示计算机的内存空间,其中的小矩形代表进程,左下角的圆 形表示磁盘,右下角的图形表示一些输入输出设备,比如鼠标键盘显示器等 等。另外,注意到内存空间被划分为了两块,上半部分表示用户空间,下半部分表示内核空间。

用户空间装着用户进程需要使用的资源,比如你在程序代码里开一个数组, 这个数组肯定存在用户空间;内核空间存放内核进程需要加载的系统资源, 这一些资源一般是不允许用户访问的。但是注意有的用户进程会共享一些内 核空间的资源,比如一些动态链接库等等。

我们用 C 语言写一个 hello 程序,编译后得到一个可执行文件,在命令行运 行就可以打印出一句 hello world,然后程序退出。在操作系统层面,就是新 建了一个进程,这个进程将我们编译出来的可执行文件读入内存空间,然后 执行,最后退出。

你编译好的那个可执行程序只是一个文件,不是进程,可执行文件必须要载 入内存,包装成一个进程才能真正跑起来。进程是要依靠操作系统创建的, 每个进程都有它的固有属性,比如进程号(PID)、进程状态、打开的文件 等等,进程创建好之后,读入你的程序,你的程序才被系统执行。

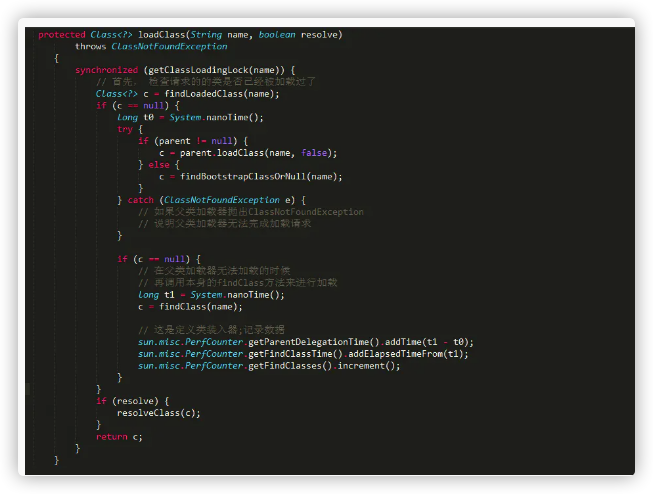

那么,操作系统是如何创建进程的呢?对于操作系统,进程就是一个数据结 构,我们直接来看 Linux 的源码:

struct task_struct {

// 进程状态

long state;

// 虚拟内存结构体

struct mm_struct *mm;

// 进程号

pid_t pid;

// 指向父进程的指针

struct task_struct __rcu *parent;

// 子进程列表

struct list_head children;

// 存放文件系统信息的指针

struct fs_struct *fs;

// 一个数组,包含该进程打开的文件指针

struct files_struct *files;

};

task_struct 就是Linux内核对于一个进程的描述,也可以称为「进程描述符」。源码比较复杂,我这里就截取了一小部分比较常⻅的。

其中比较有意思的是 mm 指针和 files 指针。 mm 指向的是进程的虚拟内 存,也就是载入资源和可执行文件的地方; files 指针指向一个数组,这 个数组里装着所有该进程打开的文件的指针。

2、文件描述符是什么

先说 files ,它是一个文件指针数组。一般来说,一个进程会 从 files[0] 读取输入,将输出写入 files[1] ,将错误信息写 入 files[2] 。

举个例子,以我们的角度 C 语言的 printf 函数是向命令行打印字符,但是 从进程的角度来看,就是向 files[1] 写入数据;同理, scanf函数就是进程试图从files[0] 这个文件中读取数据。

每个进程被创建时, files 的前三位被填入默认值,分别指向标准输入 流、标准输出流、标准错误流。我们常说的「文件描述符」就是指这个文件 指针数组的索引,所以程序的文件描述符默认情况下 0 是输入,1 是输出, 2 是错误。

我们可以重新画一幅图:

对于一般的计算机,输入流是键盘,输出流是显示器,错误流也是显示器, 所以现在这个进程和内核连了三根线。因为硬件都是由内核管理的,我们的 进程需要通过「系统调用」让内核进程访问硬件资源。

PS:不要忘了,Linux 中一切都被抽象成文件,设备也是文件,可以进行读 和写。

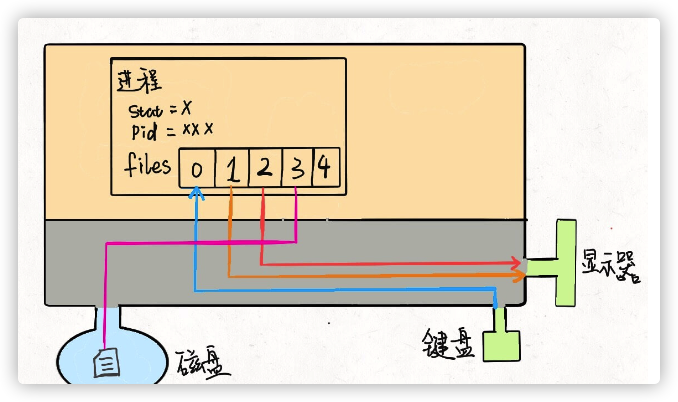

如果我们写的程序需要其他资源,比如打开一个文件进行读写,这也很简单,进行系统调用,让内核把文件打开,这个文件就会被放到 files 的第 4 个位置:

明白了这个原理,输入重定向就很好理解了,程序想读取数据的时候就会 去 files[0] 读取,所以我们只要把 files[0] 指向一个文件,那么程序就会 从这个文件中读取数据,而不是从键盘:

$ command < file.txt

同理,输出重定向就是把 files[1] 指向一个文件,那么程序的输出就不会写入到显示器,而是写入到这个文件中:

错误重定向也是一样的,就不再赘述。 管道符其实也是异曲同工,把一个进程的输出流和另一个进程的输入流接起 一条「管道」,数据就在其中传递,不得不说这种设计思想真的很优美:

$ command > file.txt

$ cmd1 | cmd2 | cmd3

到这里,你可能也看出「Linux 中一切皆文件」设计思路的高明了,不管是 设备、另一个进程、socket 套接字还是真正的文件,全部都可以读写,统一 装进一个简单的 files 数组,进程通过简单的文件描述符访问相应资源, 具体细节交于操作系统,有效解耦,优美高效。

3、线程是什么

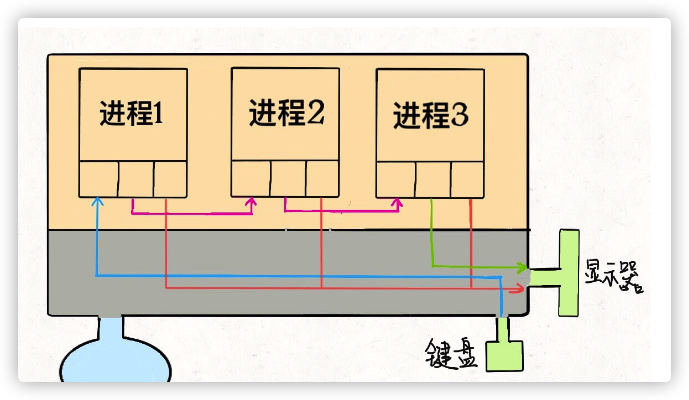

首先要明确的是,多进程和多线程都是并发,都可以提高处理器的利用效率,所以现在的关键是,多线程和多进程有啥区别。

为什么说 Linux 中线程和进程基本没有区别呢,因为从 Linux 内核的角度来 看,并没有把线程和进程区别对待。

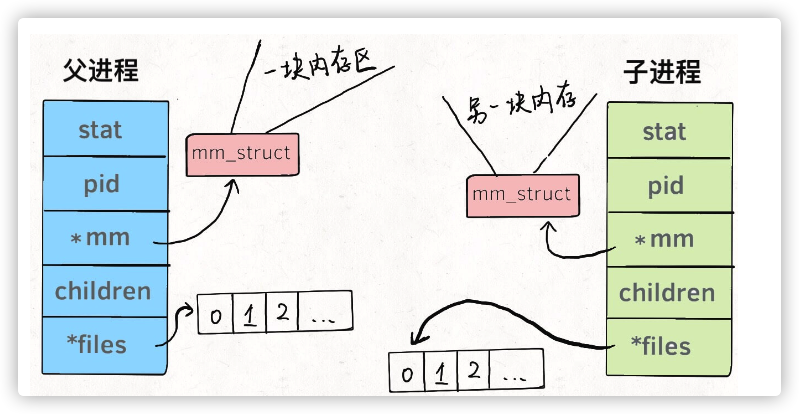

我们知道系统调用 fork() 可以新建一个子进程,函数 pthread() 可以新建 一个线程。但无论线程还是进程,都是用task_struct结构表示的,唯一的 区别就是共享的数据区域不同。

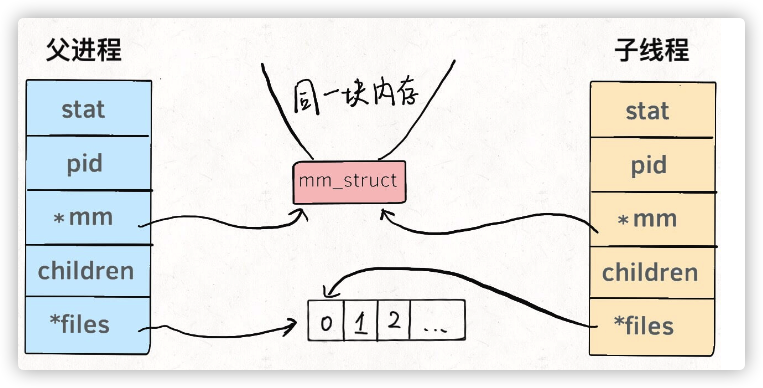

换句话说,线程看起来跟进程没有区别,只是线程的某些数据区域和其父进 程是共享的,而子进程是拷⻉副本,而不是共享。就比如说, mm 结构 和 files 结构在线程中都是共享的,我画两张图你就明白了:

所以说,我们的多线程程序要利用锁机制,避免多个线程同时往同一区域写 入数据,否则可能造成数据错乱。

那么你可能问,既然进程和线程差不多,而且多进程数据不共享,即不存在 数据错乱的问题,为什么多线程的使用比多进程普遍得多呢?

因为现实中数据共享的并发更普遍呀,比如十个人同时从一个账户取十元, 我们希望的是这个共享账户的余额正确减少一百元,而不是希望每人获得一 个账户的拷⻉,每个拷⻉账户减少十元。

当然,必须要说明的是,只有 Linux 系统将线程看做共享数据的进程,不对 其做特殊看待,其他的很多操作系统是对线程和进程区别对待的,线程有其 特有的数据结构,我个人认为不如 Linux 的这种设计简洁,增加了系统的复 杂度。

在 Linux 中新建线程和进程的效率都是很高的,对于新建进程时内存区域拷 ⻉的问题,Linux 采用了 copy-on-write 的策略优化,也就是并不真正复制父 进程的内存空间,而是等到需要写操作时才去复制。所以 Linux 中新建进 程和新建线程都是很迅速的。

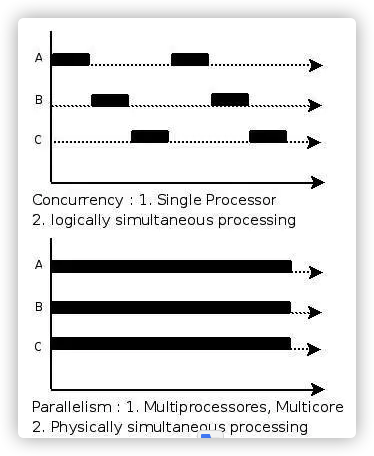

二、说说并发与并行的区别?

- 并发:一个处理器同时处理多个任务。

- 并行:多个处理器或者是多核的处理器同时处理多个不同的任务.

前者是逻辑上的同时发生(simultaneous),而后者是物理上的同时发生.

- 并发性(concurrency),又称共行性,是指能处理多个同时性活动的能力,并发事件之间不一定要同一时刻发生。

- 并行(parallelism)是指同时发生的两个并发事件,具有并发的含义,而并发则不一定并行。

来个比喻:并发和并行的区别就是一个人同时吃三个馒头和三个人同时吃三个馒头。

并发与并行的区别

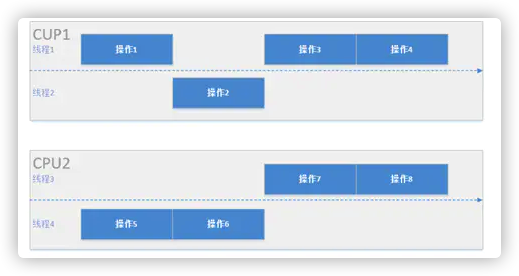

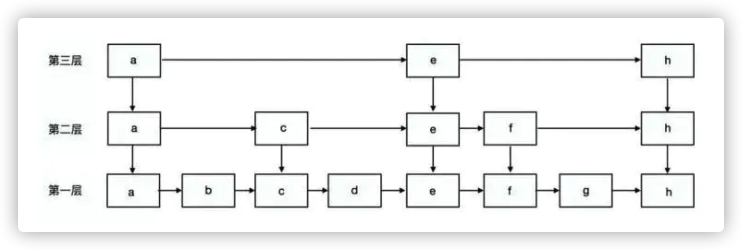

下图反映了一个包含8个操作的任务在一个有两核心的CPU中创建四个线程运行的情况。假设每个核心有两个线程,那么每个CPU中两个线程会交替并发,两个CPU之间的操作会并行运算。单就一个CPU而言两个线程可以解决线程阻塞造成的不流畅问题,其本身运行效率并没有提高,多CPU的并行运算才真正解决了运行效率问题,这也正是并发和并行的区别。

三、为什么要使用多线程呢?

从系统应用上来思考:

- 线程可以比作是轻量级的进程,是程序执行的最小单位,线程间切换和调度的成本远远小于进程。另外,多核 CPU 时代,意味着多个线程可以同时运行,这减少了线程上下文切换的开销;

- 如今的系统,动不动就要求百万级甚至亿万级的并发量,而多线程并发编程,正是开发高并发系统的基础,利用好多线程机制,可以大大提高系统整体的并发能力以及性能。

从计算机背后来探讨:

单核时代: 在单核时代,多线程主要是为了提高 CPU 和 IO 设备的综合利用率。举个例子:当只有一个线程工作的时候,会导致 CPU 计算时,IO 设备空闲;进行 IO 操作时,CPU 空闲。可以简单地理解成,这两者的利用率最高都是 50%左右。但是当有两个线程的时候就不一样了,一个线程执行 CPU 计算时,另外一个线程就可以进行 IO 操作,这样 CPU 和 IO 设备两个的利用率就可以在理想情况下达到 100%;

多核时代: 多核时代多线程主要是为了提高 CPU 利用率。举个例子:假如我们要计算一个复杂的任务,我们只用一个线程的话,CPU 只有一个 CPU 核心被利用到,而创建多个线程,就可以让多个 CPU 核心被利用到,这样就提高了 CPU 的利用率。

四、创建线程有哪几种方式?(a.继承 Thread 类;b.实现 Runnable 接口;c. 使用 Executor 框架;d.使用 FutureTask)

五、说说线程的生命周期和状态?

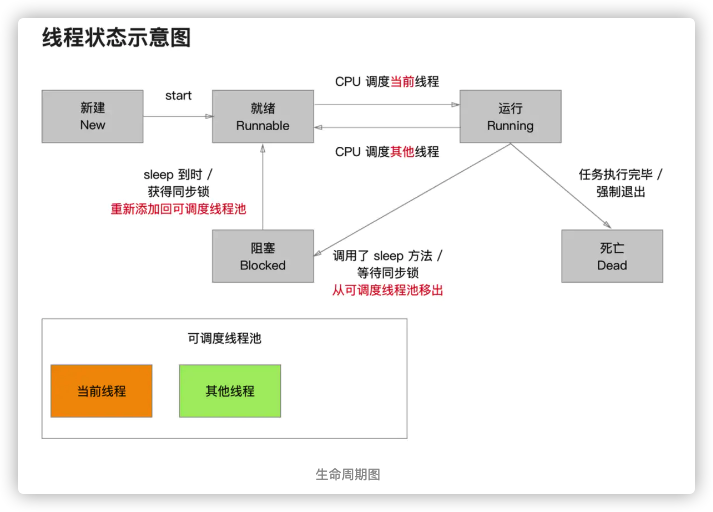

那么现在我们来了解线程一个完整的生命周期的运行过程,与下图可以看出有:新建 - 就绪 - 运行 - 阻塞 - 死亡五个过程。

下面我们一个一个的来介绍:

- 新建:刚刚创建还在内存当中,还没有在可调度线程池中,还不能被cpu调度执行工作。

- 就绪:进入调度池,可被调度。

- 运行:CPU负责调度”可调度线程池”中的处于”就绪状态”的线程,线程执行结束之前,状态可能会在”就绪”和”运行”之间来回的切换。“就绪”和”运行”之间的状态切换由CPU来完成,程序员无法干涉

- 阻塞:正在运行的线程,当满足某个条件时,可以用休眠或者锁来阻塞线程的执行,被移出调度池,进入内存,不可执行。

- 死亡:分为两种情况。正常死亡,线程执行结束。非正常死亡,程序突然崩溃/当满足某个条件后,在线程内部强制线程退出,调用exit方法。

exit方法的作用和总结

使当前线程退出.

不能在主线程中调用该方法,会使主线程退出.

当前线程死亡之后,这个线程中的代码都不会被执行.

在调用此方法之前一定要注意释放之前由C语言框架创建的对象.

六、什么是上下文切换?

现在linux是大多基于抢占式,CPU给每个任务一定的服务时间,当时间片轮转的时候,需要把当前状态保存下来,同时加载下一个任务,这个过程叫做上下文切换。时间片轮转的方式,使得多个任务利用一个CPU执行成为可能,但是保存现场和加载现场,也带来了性能消耗。 那线程上下文切换的次数和时间以及性能消耗如何看呢?

上下文切换的性能消耗在哪里呢? context switch过高,会导致CPU像个搬运工,频繁在寄存器和运行队列直接奔波 ,更多的时间花在了线程切换,而不是真正工作的线程上。直接的消耗包括CPU寄存器需要保存和加载,系统调度器的代码需要执行。间接消耗在于多核cache之间的共享数据。

引起上下文切换的原因有哪些? 对于抢占式操作系统而言, 大体有几种: 1、当前任务的时间片用完之后,系统CPU正常调度下一个任务; 2、当前任务碰到IO阻塞,调度线程将挂起此任务,继续下一个任务; 3、多个任务抢占锁资源,当前任务没有抢到,被调度器挂起,继续下一个任务; 4、用户代码挂起当前任务,让出CPU时间; 5、硬件中断; 监测Linux的应用的时候,当CPU的利用率非常高,但是系统的性能却上不去的时候,不妨监控一下线程/进程的切换,看看是不是context switching导致的overhead过高。 常用命令: pidstat vmstat

七、什么是线程死锁?如何避免死锁?

死锁

当线程A持有独占锁a,并尝试去获取独占锁b的同时,线程B持有独占锁b,并尝试获取独占锁a的情况下,就会发生AB两个线程由于互相持有对方需要的锁,而发生的阻塞现象,我们称为死锁。

下面用一个非常简单的死锁示例来帮助你理解死锁的定义。

public class DeadLockDemo {

public static void main(String[] args) {

// 线程a

Thread td1 = new Thread(new Runnable() {

public void run() {

DeadLockDemo.method1();

}

});

// 线程b

Thread td2 = new Thread(new Runnable() {

public void run() {

DeadLockDemo.method2();

}

});

td1.start();

td2.start();

}

public static void method1() {

synchronized (String.class) {

try {

Thread.sleep(2000);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("线程a尝试获取integer.class");

synchronized (Integer.class) {

}

}

}

public static void method2() {

synchronized (Integer.class) {

try {

Thread.sleep(2000);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("线程b尝试获取String.class");

synchronized (String.class) {

}

}

}

}

----------------

线程b尝试获取String.class

线程a尝试获取integer.class

....

...

..

.

无限阻塞下去

如何避免死锁?

教科书般的回答应该是,结合“哲学家就餐“模型,分析并总结出以下死锁的原因,最后得出“避免死锁就是破坏造成死锁的,若干条件中的任意一个”的结论。

造成死锁必须达成的4个条件(原因):

- 互斥条件:一个资源每次只能被一个线程使用。

- 请求与保持条件:一个线程因请求资源而阻塞时,对已获得的资源保持不放。

- 不剥夺条件:线程已获得的资源,在未使用完之前,不能强行剥夺。

- 循环等待条件:若干线程之间形成一种头尾相接的循环等待资源关系。

但是,“哲学家就餐”光看名字就很讨厌,然后以上这4个条件看起来也很绕口,再加上笔者又是个懒人,所以要让我在面试时把这些“背诵”出来实在是太难了!必须要想办法把这4个条件简化一下! 于是,通过对4个造成死锁的条件进行逐条分析,我们可以得出以下4个结论。

- 互斥条件 —> 独占锁的特点之一。

- 请求与保持条件 —> 独占锁的特点之一,尝试获取锁时并不会释放已经持有的锁

- 不剥夺条件 —> 独占锁的特点之一。

- 循环等待条件 —> 唯一需要记忆的造成死锁的条件。

不错!复杂的死锁条件经过简化,现在需要记忆的仅只有独占锁与第四个条件而已。

所以,面对如何避免死锁这个问题,我们只需要这样回答! : 在并发程序中,避免了逻辑中出现复数个线程互相持有对方线程所需要的独占锁的的情况,就可以避免死锁。

下面我们通过“破坏”第四个死锁条件,来解决第一个小节中的死锁示例并证明我们的结论。

public class DeadLockDemo2 {

public static void main(String[] args) {

// 线程a

Thread td1 = new Thread(new Runnable() {

public void run() {

DeadLockDemo2.method1();

}

});

// 线程b

Thread td2 = new Thread(new Runnable() {

public void run() {

DeadLockDemo2.method2();

}

});

td1.start();

td2.start();

}

public static void method1() {

synchronized (String.class) {

try {

Thread.sleep(2000);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("线程a尝试获取integer.class");

synchronized (Integer.class) {

System.out.println("线程a获取到integer.class");

}

}

}

public static void method2() {

// 不再获取线程a需要的Integer.class锁。

synchronized (String.class) {

try {

Thread.sleep(2000);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("线程b尝试获取Integer.class");

synchronized (Integer.class) {

System.out.println("线程b获取到Integer.class");

}

}

}

}

-----------------

线程a尝试获取integer.class

线程a获取到integer.class

线程b尝试获取Integer.class

线程b获取到Integer.class

在上面的例子中,由于已经不存在线程a持有线程b需要的锁,而线程b持有线程a需要的锁的逻辑了,所以Demo顺利执行完毕。

总结

是否能够简单明了的在面试中阐述清楚死锁产生的原因,并给出解决死锁的方案,可以体现程序员在面对对并发问题时思路是否清晰,对并发的基础掌握是否牢固等等。 而且在实际项目中并发模块的逻辑往往比本文的示例复杂许多,所以写并发应用之前一定要充分理解本文所总结的要点,并切记,并发程序编程在不显著影响程序性能的情况下,一定要尽可能的保守。

八、说说 sleep() 方法和 wait() 方法区别和共同点?

1.方法来源区别

wait方法定义在Object上,Thread.sleep()定义在Thread上(这很重要,定义决定作用范围)

2.关于锁和cpu

结论:二者都释放cpu,wait()释放锁,Thread.sleep()不会释放锁. 解释如下: 1.别管是Object.wait()还是Thread.sleep(),都是暂停执行,所以这里都会释放cpu. 2.Object.wait()方法是对象拥有,然后对象锁又是在synchronized同步代码块中使用,所以Object.wait()方法拥有锁的控制权,所以他会释放锁资源.而Thread.sleep()是Thread上的静态方法,所以只能使当前线程睡眠,但是它和锁没有任何关系,所以就没有锁的释放这一问题.

3.作用范围

- Object.wait()方法只能在synchronized快中调用,并且需要和notify和notifyAll配合使用.

- Thread.sleep()是可以在任何上下文调用的,注意是暂停当前的线程 所以就方法而言,Object.wait()主要用在多线程之间的协同工作,Thread.sleep()主要是控制一个线程的执行时间长短.

4 关于异常

Object.wait()方法和Thread.sleep()都抛出 InterruptedException,并且方法定义为final, 所以方法不能被重写,那么在使用 该方法时就只能 try()catch(){}异常,(为什么说只能try,因为如果不捕获异常,那么也意味着你的方法抛出的异常就只能是InterruptedException,或者它的子类,所以这里一般都是捕获异常并处理异常,可以在catch中抛出其他异常)

九、synchronized 关键字、volatile 关键字

- volatile是通知jvm当前变量在寄存器或者cpu中的值是不确定的,需要从主存中读取。不会阻塞线程。

- synchronized则是通过锁机制来控制变量是否可以访问。当变量被锁时,其他线程访问变量将被阻塞,直至锁释放。

volatile

- volatile保证其他线程对这个变量操作时是立即可见的,即操作的是从内存中读取的最新值

- 无法保证原子性

- 只能修饰变量

public class Test {

private volatile int count;

public void increase() {

count++;

System.out.println("----" + count);

}

public static void main(String[] args) throws Exception {

Test test = new Test();

for (int i = 0; i < 10; i++) {

new Thread() {

public void run() {

for (int j = 0; j < 10; j++) {

test.increase();

}

};

}.start();

}

}

}

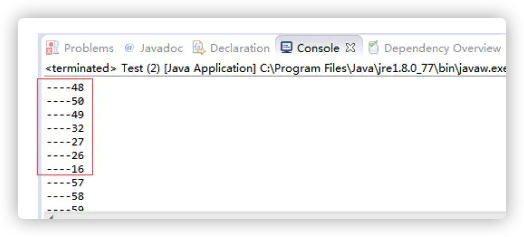

- 控制台输出:

控制台输出

- 使用场景(DCL双重检测锁):

class Singleton{

private volatile static Singleton instance = null;

private Singleton() {}

public static Singleton getInstance() {

if(instance==null) {

synchronized (Singleton.class) {

if(instance==null)

instance = new Singleton();

}

}

return instance;

}

}

synchronized

- 保证原子性

- 即可修饰变量也可修饰方法

- 会阻塞线程

1)synchronized非静态方法

public class Test {

public synchronized void increase1() {

for (int i = 0; i < 5; i++) {

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

System.out.println("increase1---->" + i);

}

}

public synchronized void increase2() {

for (int i = 0; i < 5; i++) {

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

System.out.println("increase2---->" + i);

}

}

public static void main(String[] args) throws Exception {

Test test = new Test();

new Thread() {

public void run() {

test.increase1();

};

}.start();

new Thread() {

public void run() {

test.increase2();

};

}.start();

}

}

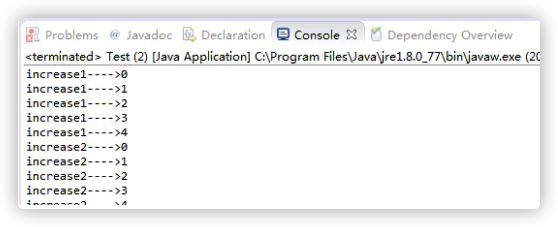

- 控制台输出:

- 结论:

如果一个对象有多个synchronized方法,多个线程同时调用该对象的方法,将会同步执行,即同时只能有一个synchronized方法被调用,其他调用将被阻塞直至该方法执行完

2)synchronized静态方法

懒。。 直接给结论了

synchronized静态方法和非静态方法的区别在于给方法上锁的对象不一样,非静态方法是给调用的对象上锁,静态方法是给类的Class对象上锁

3)synchronized块

public class Test {

public void increase1() {

System.out.println("increase1----------> start");

synchronized (this) {

for (int i = 0; i < 5; i++) {

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

System.out.println("increase1---->" + i);

}

}

System.out.println("increase1----------> end");

}

public void increase2() {

System.out.println("increase2----------> start");

synchronized(this) {

for (int i = 0; i < 5; i++) {

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

System.out.println("increase2---->" + i);

}

}

System.out.println("increase2----------> end");

}

public static void main(String[] args) throws Exception {

Test test = new Test();

new Thread() {

public void run() {

test.increase1();

};

}.start();

new Thread() {

public void run() {

test.increase2();

};

}.start();

}

}

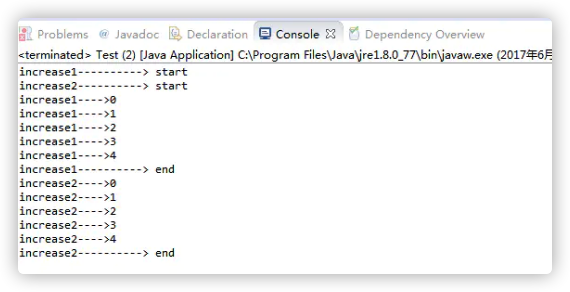

- 控制台输出:

- 结论

synchronized方法是控制同时只能有一个线程执行synchronized方法;synchronized块是控制同时只能有一个线程执行synchronized块中的内容

十、ThreadLocal 有啥用(解决了什么问题)?怎么用?原理了解吗?内存泄露问题了解吗?

ThreadLoacl是什么

在了解ThreadLocal之前,我们先了解下什么是线程封闭

把对象封闭在一个线程里,即使这个对象不是线程安全的,也不会出现并发安全问题。

实现线程封闭大致有三种方式:

- Ad-hoc线程封闭:维护线程封闭性的职责完全由程序来承担,不推荐使用

- 栈封闭:就是用栈(stack)来保证线程安全

public void testThread() {

StringBuilder sb = new StringBuilder();

sb.append("Hello");

}

StringBuilder是线程不安全的,但是它只是个局部变量,局部变量存储在虚拟机栈,虚拟机栈是线程隔离的,所以不会有线程安全问题

- ThreadLocal线程封闭:简单易用

第三种方式就是通过ThreadLocal来实现线程封闭,线程封闭的指导思想是封闭,而不是共享。所以说ThreadLocal是用来解决变量共享的并发安全问题,多少有些不精确。

使用

JDK1.2开始提供的java.lang.ThreadLocal的使用方式非常简单

public class ThreadLocalDemo {

public static void main(String[] args) throws InterruptedException {

final ThreadLocal<String> threadLocal = new ThreadLocal<>();

threadLocal.set("main-thread : Hello");

Thread thread = new Thread(() -> {

// 获取不到主线程设置的值,所以为null

System.out.println(threadLocal.get());

threadLocal.set("sub-thread : World");

System.out.println(threadLocal.get());

});

// 启动子线程

thread.start();

// 让子线程先执行完成,再继续执行主线

thread.join();

// 获取到的是主线程设置的值,而不是子线程设置的

System.out.println(threadLocal.get());

threadLocal.remove();

System.out.println(threadLocal.get());

}

}

运行结果

null

sub-thread : World

main-thread : Hello

null

运行结果说明了ThreadLocal只能获取本线程设置的值,也就是线程封闭。基本上,ThreadLocal对外提供的方法只有三个get()、set(T)、remove()。

原理

使用方式非常简单,所以我们来看看ThreadLocal的源码。ThreadLocal内部定义了一个静态ThreadLocalMap类,ThreadLocalMap内部又定义了一个Entry类,这里只看一些主要的属性和方法

public class ThreadLocal<T> {

public T get() {

Thread t = Thread.currentThread();

ThreadLocalMap map = getMap(t);

if (map != null) {

ThreadLocalMap.Entry e = map.getEntry(this);

if (e != null) {

@SuppressWarnings("unchecked")

T result = (T)e.value;

return result;

}

}

return setInitialValue();

}

public void set(T value) {

Thread t = Thread.currentThread();

ThreadLocalMap map = getMap(t);

if (map != null)

map.set(this, value);

else

createMap(t, value);

}

public void remove() {

ThreadLocalMap m = getMap(Thread.currentThread());

if (m != null)

m.remove(this);

}

// 从这里可以看出ThreadLocalMap对象是被Thread类持有的

ThreadLocalMap getMap(Thread t) {

return t.threadLocals;

}

void createMap(Thread t, T firstValue) {

t.threadLocals = new ThreadLocalMap(this, firstValue);

}

// 内部类ThreadLocalMap

static class ThreadLocalMap {

static class Entry extends WeakReference<ThreadLocal<?>> {

Object value;

// 内部类Entity,实际存储数据的地方

// Entry的key是ThreadLocal对象,不是当前线程ID或者名称

Entry(ThreadLocal<?> k, Object v) {

super(k);

value = v;

}

}

// 注意这里维护的是Entry数组

private Entry[] table;

}

}

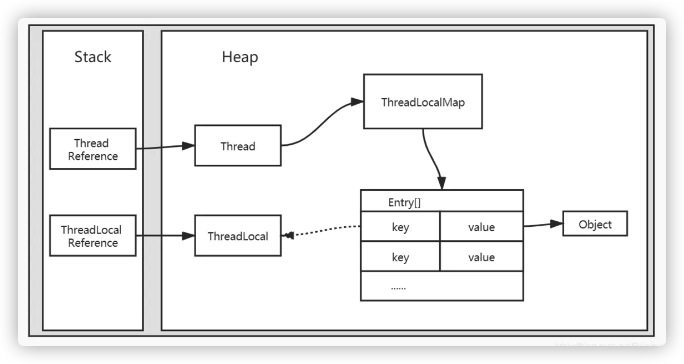

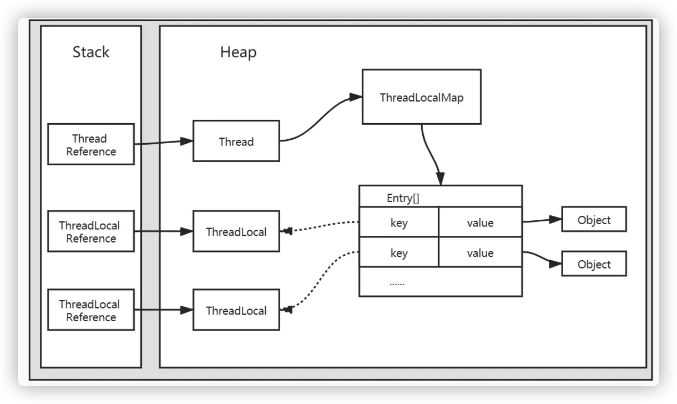

根据上面的源码,可以大致画出ThreadLocal在虚拟机内存中的结构

实线箭头表示强引用,虚线箭头表示弱引用。需要注意的是:

- ThreadLocalMap虽然是在ThreadLocal类中定义的,但是实际上被Thread持有。

- Entry的key是(虚引用的)ThreadLocal对象,而不是当前线程ID或者线程名称。

- ThreadLocalMap中持有的是Entry数组,而不是Entry对象。

对于第一点,ThreadLocalMap被Thread持有是为了实现每个线程都有自己独立的ThreadLocalMap对象,以此为基础,做到线程隔离。第二点和第三点理解,我们先来想一个问题,如果同一个线程中定义了多个ThreadLocal对象,内存结构应该是怎样的?此时再来看一下ThreadLocal.set(T)方法:

public void set(T value) {

// 获取当前线程对象

Thread t = Thread.currentThread();

// 根据线程对象获取ThreadLocalMap对象(ThreadLocalMap被Thread持有)

ThreadLocalMap map = getMap(t);

// 如果ThreadLocalMap存在,则直接插入;不存在,则新建ThreadLocalMap

if (map != null)

map.set(this, value);

else

createMap(t, value);

}

也就是说,如果程序定义了多个ThreadLocal,会共用一个ThreadLocalMap对象,所以内存结构应该是这样

这个内存结构图解释了第二点和第三点。假设Entry中key为当前线程ID或者名称的话,那么程序中定义多个ThreadLocal对象时,Entry数组中的所有Entry的key都一样(或者说只能存一个value)。ThreadLocalMap中持有的是Entry数组,而不是Entry,则是因为程序可定义多个ThreadLocal对象,自然需要一个数组。

内存泄漏

ThreadLocal会发生内存泄漏吗?

会

仔细看下ThreadLocal内存结构就会发现,Entry数组对象通过ThreadLocalMap最终被Thread持有,并且是强引用。也就是说Entry数组对象的生命周期和当前线程一样。即使ThreadLocal对象被回收了,Entry数组对象也不一定被回收,这样就有可能发生内存泄漏。ThreadLocal在设计的时候就提供了一些补救措施:

- Entry的key是弱引用的ThreadLocal对象,很容易被回收,导致key为null(但是value不为null)。所以在调用get()、set(T)、remove()等方法的时候,会自动清理key为null的Entity。

- remove()方法就是用来清理无用对象,防止内存泄漏的。所以每次用完ThreadLocal后需要手动remove()。

有些文章认为是弱引用导致了内存泄漏,其实是不对的。假设把弱引用变成强引用,这样无用的对象key和value都不为null,反而不利于GC,只能通过remove()方法手动清理,或者等待线程结束生命周期。也就是说ThreadLocalMap的生命周期由持有它的线程来决定,线程如果不进入terminated状态,ThreadLocalMap就不会被GC回收,这才是ThreadLocal内存泄露的原因。

应用场景

- 维护JDBC的java.sql.Connection对象,因为每个线程都需要保持特定的Connection对象。

- Web开发时,有些信息需要从controller传到service传到dao,甚至传到util类。看起来非常不优雅,这时便可以使用ThreadLocal来优雅的实现。

- 包括线程不安全的工具类,比如Random、SimpleDateFormat等

与synchronized的关系

有些文章拿ThreadLocal和synchronized比较,其实它们的实现思想不一样。

- synchronized是同一时间最多只有一个线程执行,所以变量只需要存一份,算是一种时间换空间的思想

- ThreadLocal是多个线程互不影响,所以每个线程存一份变量,算是一种空间换时间的思想

总结

ThreadLocal是一种隔离的思想,当一个变量需要进行线程隔离时,就可以考虑使用ThreadLocal来优雅的实现。

十一、为什么要用线程池?ThreadPoolExecutor 类的重要参数了解吗?ThreadPoolExecutor 饱和策略了解吗?线程池原理了解吗?几种常见的线程池了解吗?为什么不推荐使用FixedThreadPool?如何设置线程池的大小?

十二、AQS 了解么?原理?AQS 常用组件:Semaphore (信号量)、CountDownLatch (倒计时器) CyclicBarrier(循环栅栏)

1 AQS 概述

AQS 的全称为(AbstractQueuedSynchronizer),中文即“队列同步器”,这个类放在 java.util.concurrent.locks 包下面。

AQS是用来构建锁或者其他同步组件的基础框架,它使用了一个int成员变量表示同步状态,通过内置的FIFO队列来完成资源获取线程的排队工作。使用 AQS 能简单且高效地构造出应用广泛的大量的同步器,比如上篇文章写的ReentrantLock与ReentrantReadWriteLock。除此之外,AQS还能构造出Semaphore,FutureTask(jdk1.7) 等同步器。

2 AQS 原理

2.1 同步队列

AQS 是依赖 CLH 队列锁来完成同步状态的管理。当前线程获取同步状态失败时,同步器会将当前线程以及等待状态等信息构建为一个**节点(Node)**并将其加入同步队列,同步会阻塞当前线程,当同步状态释放时,会将首节点中的线程唤醒,使其再次尝试获取同步状态。

CLH(Craig,Landin,and Hagersten)队列是一个虚拟的双向队列(FIFO双向队列)(虚拟的双向队列即不存在队列实例,仅存在结点之间的关联关系)。AQS 是将每条请求共享资源的线程封装成一个 CLH 锁队列的一个结点(Node)来实现锁的分配。

同步队列中的节点(Node)用来保存获取同步状态失败的线程引用、等待状态以及前驱和后继节点信息。

| 属性类型与名称 | 描述 |

|---|---|

| int waitStatus | 等待状态(如CANCELLED=1、SIGNAL=-1、CONDITION=-2、PROPAGATE=-3、INITIAL=0) |

| Node prev | 前驱节点(当节点加入同步队列时被设置,在尾部添加) |

| Node next | 后继节点 |

| Thread thread | 当前获取同步状态的线程 |

节点源码如下:

static final class Node {

// 表示该节点等待模式为共享式,通常记录于nextWaiter,

// 通过判断nextWaiter的值可以判断当前结点是否处于共享模式

static final Node SHARED = new Node();

// 表示节点处于独占式模式,与SHARED相对

static final Node EXCLUSIVE = null;

// waitStatus的不同状态

// 当前结点是因为超时或者中断取消的,进入该状态后将无法恢复

static final int CANCELLED = 1;

// 当前结点的后继结点是(或者将要)由park导致阻塞的,当结点被释放或者取消时,需要通过unpark唤醒后继结点

static final int SIGNAL = -1;

// 表明结点在等待队列中,结点线程等待在Condition上

// 当其他线程对Condition调用了signal()方法时,会将其加入到同步队列中

static final int CONDITION = -2;

// 下一次共享式同步状态的获取将会无条件地向后继结点传播

static final int PROPAGATE = -3;

volatile int waitStatus;

// 记录前驱结点

volatile Node prev;

// 记录后继结点

volatile Node next;

// 记录当前的线程

volatile Thread thread;

// 用于记录共享模式(SHARED), 也可以用来记录CONDITION队列

Node nextWaiter;

// 通过nextWaiter的记录值判断当前结点的模式是否为共享模式

final boolean isShared() { return nextWaiter == SHARED;}

// 获取当前结点的前置结点

final Node predecessor() throws NullPointerException { ... }

// 用于初始化时创建head结点或者创建SHARED结点

Node() {}

// 在addWaiter方法中使用,用于创建一个新的结点

Node(Thread thread, Node mode) {

this.nextWaiter = mode;

this.thread = thread;

}

// 在CONDITION队列中使用该构造函数新建结点

Node(Thread thread, int waitStatus) {

this.waitStatus = waitStatus;

this.thread = thread;

}

}

// 记录头结点

private transient volatile Node head;

// 记录尾结点

private transient volatile Node tail;

节点是构成同步队列的基础,同步器拥有首节点(Head)和尾节点(Tail),没有成功获取同步状态的线程将会成为节点加入该队列的尾部。同步器提供了一个基于CAS的设置尾节点的方法:compareAndSetTail(Node expect, Node update),它需要传递当前线程“认为”的尾节点和当前节点,只有设置成功后,当前节点才正式与之前的尾节点建立关联。

首节点是获取同步状态成功的节点,首节点的线程在释放同步状态时,将会唤醒后继节点,而后继节点将会在获取同步状态成功时将自己设置为首节点。设置首节点是通过获取同步状态成功的线程来完成的,不需要使用CAS来保证,只需将首节点设置成为原首节点的后继节点并断开原首节点的next引用即可。

2.2 同步状态

1) 独占式(EXCLUSIVE)

独占式(EXCLUSIVE)获取需重写tryAcquire、tryRelease方法,并访问acquire、release方法实现相应的功能。

public final void acquire(int arg) {

// 如果线程直接获取成功,或者再尝试获取成功后都是直接工作,

// 如果是从阻塞状态中唤醒开始工作的线程,将当前的线程中断

if (!tryAcquire(arg) &&

acquireQueued(addWaiter(Node.EXCLUSIVE), arg))

selfInterrupt();

}

// 封装线程,新建结点并加入到同步队列中

private Node addWaiter(Node mode) {

Node node = new Node(Thread.currentThread(), mode);

Node pred = tail;

// 尝试入队, 成功返回

if (pred != null) {

node.prev = pred;

// CAS操作设置队尾

if (compareAndSetTail(pred, node)) {

pred.next = node;

return node;

}

}

// 通过CAS操作自旋完成node入队操作

enq(node);

return node;

}

// 在同步队列中等待获取同步状态

final boolean acquireQueued(final Node node, int arg) {

boolean failed = true;

try {

boolean interrupted = false;

// 自旋

for (;;) {

final Node p = node.predecessor();

// 前驱节点是否为头节点&&tryAcquire获取同步状态

if (p == head && tryAcquire(arg)) {

setHead(node);

p.next = null;

failed = false;

return interrupted;

}

// 获取不到同步状态,将前置结点标为SIGNAL状态并且通过park操作将Node封装的线程阻塞

if (shouldParkAfterFailedAcquire(p, node) &&

parkAndCheckInterrupt())

interrupted = true;

}

} finally {

if (failed)

// 如果获取失败,将node标记为CANCELLED

cancelAcquire(node);

}

}

独占式获取同步状态流程:

通过调用同步器的release(int arg)方法可以释放同步状态,该方法在释放了同步状态之后,会唤醒其后继节点(进而使后继节点重新尝试获取同步状态)。

public final boolean release(int arg) {

// 首先尝试释放并更新同步状态

if (tryRelease(arg)) {

Node h = head;

// 检查是否需要唤醒后置结点

if (h != null && h.waitStatus != 0)

// 唤醒后置结点

unparkSuccessor(h);

return true;

}

return false;

}

// 唤醒后继结点

private void unparkSuccessor(Node node) {

int ws = node.waitStatus;

// 通过CAS操作将waitStatus更新为0

if (ws < 0)

compareAndSetWaitStatus(node, ws, 0);

Node s = node.next;

// 检查后置结点,若为空或者状态为CANCELLED,找到后置非CANCELLED结点

if (s == null || s.waitStatus > 0) {

s = null;

for (Node t = tail; t != null && t != node; t = t.prev)

if (t.waitStatus <= 0)

s = t;

}

// 唤醒后继结点

if (s != null)

LockSupport.unpark(s.thread);

}

2)共享式(SHARED)

共享式获取与独占式获取最主要的区别在于同一时刻能否有多个线程同时获取到同步状态。

共享式(SHARED)获取需重写tryAcquireShared、tryReleaseShared方法,并访问acquireShared、releaseShared方法实现相应的功能。与独占式相对,共享式支持多个线程同时获取到同步状态并进行工作,如 Semaphore、CountDownLatch、 CyclicBarrier等。ReentrantReadWriteLock 可以看成是组合式,因为 ReentrantReadWriteLock 也就是读写锁允许多个线程同时对某一资源进行读。

public final void acquireShared(int arg) {

// 尝试共享式获取同步状态,如果成功获取则可以继续执行,否则执行doAcquireShared

if (tryAcquireShared(arg) < 0)

// 以共享式不停得尝试获取同步状态

doAcquireShared(arg);

}

private void doAcquireShared(int arg) {

// 向同步队列中新增一个共享式的结点

final Node node = addWaiter(Node.SHARED);

// 标记获取失败状态

boolean failed = true;

try {

// 标记中断状态(若在该过程中被中断是不会响应的,需要手动中断)

boolean interrupted = false;

// 自旋

for (;;) {

// 获取前置结点

final Node p = node.predecessor();

// 若前置结点为头结点

if (p == head) {

// 尝试获取同步状态

int r = tryAcquireShared(arg);

// 若获取到同步状态。

if (r >= 0) {

// 此时,当前结点存储的线程恢复执行,需要将当前结点设置为头结点并且向后传播,

// 通知符合唤醒条件的结点一起恢复执行

setHeadAndPropagate(node, r);

p.next = null;

// 需要中断,中断当前线程

if (interrupted)

selfInterrupt();

// 获取成功

failed = false;

return;

}

}

// 获取同步状态失败,需要进入阻塞状态

if (shouldParkAfterFailedAcquire(p, node) &&

parkAndCheckInterrupt())

interrupted = true;

}

} finally {

// 获取失败,CANCELL node

if (failed)

cancelAcquire(node);

}

}

// 将node设置为同步队列的头结点,并且向后通知当前结点的后置结点,完成传播

private void setHeadAndPropagate(Node node, int propagate) {

Node h = head;

setHead(node);

// 向后传播

if (propagate > 0 || h == null || h.waitStatus < 0 ||

(h = head) == null || h.waitStatus < 0) {

Node s = node.next;

if(s == null || s.isShared())

doReleaseShared();

}

}

与独占式一样,共享式获取也需要释放同步状态,通过调用releaseShared(intarg)方法可以释放同步状态,释放同步状态成功后,会唤醒后置结点,并且保证传播性。

public final boolean releaseShared(int arg) {

// 尝试释放同步状态

if (tryReleaseShared(arg)) {

// 成功后唤醒后置结点

doReleaseShared();

return true;

}

return false;

}

// 唤醒后置结点

private void doReleaseShared() {

// 循环的目的是为了防止新结点在该过程中进入同步队列产生的影响,同时要保证CAS操作的完成

for (;;) {

Node h = head;

if (h != null && h != tail) {

int ws = h.waitStatus;

if (ws == Node.SIGNAL) {

if (!compareAndSetWaitStatus(h, Node.SIGNAL, 0))

continue;

unparkSuccessor(h);

}

else if (ws == 0 &&

!compareAndSetWaitStatus(h, 0, Node.PROPAGATE))

continue;

}

if (h == head)

break;

}

}

3)超时获取方式

通过调用同步器的doAcquireNanos(int arg, long nanosTimeout)方法可以超时获取同步状态,即在指定的时间段内获取同步状态,如果获取到同步状态则返回true,否则,返回false。该方法提供了传统Java同步操作(比如synchronized关键字)所不具备的特性。

private boolean doAcquireNanos(int arg, long nanosTimeout)

throws InterruptedException {

if (nanosTimeout <= 0L)

return false;

// 计算超时的时间=当前虚拟机的时间+设置的超时时间

final long deadline = System.nanoTime() + nanosTimeout;

// 调用addWaiter将当前线程封装成独占模式的节点,并且加入到同步队列尾部。

final Node node = addWaiter(Node.EXCLUSIVE);

boolean failed = true;

try {

// 自旋

for (;;) {

final Node p = node.predecessor();

if (p == head && tryAcquire(arg)) {

// 如果当前节点的前驱节点为头结点,则让当前节点去尝试获取锁。

setHead(node);

p.next = null;

failed = false;

return true;

}

// 如果当前节点的前驱节点不是头结点,或当前节点获取锁失败,

// 则再次判断当前线程是否已经超时。

nanosTimeout = deadline - System.nanoTime();

if (nanosTimeout <= 0L)

return false;

// 调用shouldParkAfterFailedAcquire方法,告诉当前节点的前驱节点,马上进入

// 等待状态了,即做好进入等待状态前的准备。

if (shouldParkAfterFailedAcquire(p, node) &&

nanosTimeout > spinForTimeoutThreshold)

// 调用LockSupport.parkNanos方法,将当前线程设置成超时等待的状态。

LockSupport.parkNanos(this, nanosTimeout);

if (Thread.interrupted())

throw new InterruptedException();

}

} finally {

if (failed)

cancelAcquire(node);

}

}

由上面代码可知,超时获取也是调用addWaiter将当前线程封装成独占模式的节点,并且加入到同步队列尾部。

超时获取与独占式获取同步状态区别在于获取同步状态失败后的处理。如果当前线程获取同步状态失败,则判断是否超时(nanosTimeout小于等于0表示已经超时);如果没有超时,重新计算超时间隔nanosTimeout,然后使当前线程等待nanosTimeout纳秒(当已到设置的超时时间,该线程会从LockSupport.parkNanos(Object blocker, long nanos)方法返回)。

独占式超时获取同步状态流程:

2.3 模板方法

AQS 使用一个 int 成员变量来表示同步状态,通过内置的 FIFO 队列来完成获取资源线程的排队工作。AQS 使用 CAS 对该同步状态进行原子操作实现对其值的修改。

private volatile int state;// 共享变量,使用volatile修饰保证线程可见性

同步状态state通过 protected 类型的getState,setState,compareAndSetState方法进行操作

// 返回同步状态的当前值

protected final int getState() {

return state;

}

// 设置同步状态的值

protected final void setState(int newState) {

state = newState;

}

// CAS更新同步状态,该方法能够保证状态设置的原子性

protected final boolean compareAndSetState(int expect, int update) {

return unsafe.compareAndSwapInt(this, stateOffset, expect, update);

}

同步器的设计是基于模板方法模式的,也就是说,使用者需要继承同步器并重写指定的方法,随后将同步器组合在自定义同步组件的实现中,并调用同步器提供的模板方法,而这些模板方法将会调用使用者重写的方法。

自定义同步器时需要重写下面几个 AQS 提供的模板方法:

isHeldExclusively()// 该线程是否正在独占资源。只有用到condition才需要去实现它。

tryAcquire(int)// 独占方式。尝试获取资源,成功则返回true,失败则返回false。

tryRelease(int)// 独占方式。尝试释放资源,成功则返回true,失败则返回false。

tryAcquireShared(int)// 共享方式。尝试获取资源。负数表示失败;0表示成功,但没有剩余可用资源;正数表示成功,且有剩余资源。

tryReleaseShared(int)// 共享方式。尝试释放资源,成功则返回true,失败则返回false。

同步器提供的模板方法基本上分为3类:独占式获取与释放同步状态、共享式获取与释放同步状态和查询同步队列中的等待线程情况。

一般来说,自定义同步器要么是独占方法,要么是共享方式,他们也只需实现tryAcquire-tryRelease、tryAcquireShared-tryReleaseShared中的一种即可。

以 ReentrantLock 为例,state 初始化为 0,表示未锁定状态。A 线程 lock()时,会调用 tryAcquire()独占该锁并将 state+1。此后,其他线程再 tryAcquire()时就会失败,直到 A 线程 unlock()到 state=0(即释放锁)为止,其它线程才有机会获取该锁。当然,释放锁之前,A 线程自己是可以重复获取此锁的(state 会累加),这就是可重入的概念。但要注意,获取多少次就要释放多么次,这样才能保证 state 是能回到零态的。

再以 CountDownLatch 以例,任务分为 N 个子线程去执行,state 也初始化为 N(注意 N 要与线程个数一致)。这 N 个子线程是并行执行的,每个子线程执行完后 countDown()一次,state 会 CAS(Compare and Swap)减 1。等到所有子线程都执行完后(即 state=0),会 unpark()主调用线程,然后主调用线程就会从 await()函数返回,继续后续动作。

但 AQS 也支持自定义同步器同时实现独占和共享两种方式,如ReentrantReadWriteLock。

下面就来学习几个常用的并发同步工具。

3 Semaphore(信号量)

Semaphore(信号量)用来控制 同时访问特定资源的线程数量,它通过协调各个线程,以保证合理的使用公共资源。synchronized 和 ReentrantLock 都是一次只允许一个线程访问某个资源,而Semaphore(信号量)可以指定多个线程同时访问某个资源。

以停车场为例。假设一个停车场只有10个车位,这时如果同时来了15辆车,则只允许其中10辆不受阻碍的进入。剩下的5辆车则必须在入口等待,此后来的车也都不得不在入口处等待。这时,如果有5辆车离开停车场,放入5辆;如果又离开2辆,则又可以放入2辆,如此往复。

在这个停车场系统中,车位即是共享资源,每辆车就好比一个线程,信号量就是空车位的数目。

Semaphore中包含了一个实现了AQS的同步器Sync,以及它的两个子类FairSync和NonFairSync。查看Semaphore类结构:

可见Semaphore也是区分公平模式和非公平模式的。

- 公平模式: 调用 acquire 的顺序就是获取许可证的顺序,遵循 FIFO。

- 非公平模式: 抢占式的。

Semaphore 对应的两个构造方法如下:

public Semaphore(int permits) {

sync = new NonfairSync(permits);

}

public Semaphore(int permits, boolean fair) {

sync = fair ? new FairSync(permits) : new NonfairSync(permits);

}

这两个构造方法,都必须提供许可的数量,第二个构造方法可以指定是公平模式还是非公平模式,默认非公平模式。

Semaphore实现原理这里就不分析了,可以参考死磕 java同步系列之Semaphore源码解析这篇文章。

需要明白的是,Semaphore也是共享锁的一种实现。它默认构造AQS的state为permits。当执行任务的线程数量超出permits,那么多余的线程将会被放入阻塞队列Park,并自旋判断state是否大于0。只有当state大于0的时候,阻塞的线程才能继续执行,此时先前执行任务的线程继续执行release方法,release方法使得state的变量会加1,那么自旋的线程便会判断成功。如此,每次只有最多不超过permits数量的线程能自旋成功,便限制了执行任务线程的数量。

Semaphore常用于做流量控制,特别是公用资源有限的应用场景。

| 常用方法 | 描述 |

|---|---|

| acquire()/acquire(int permits) | 获取许可证。获取许可失败,会进入AQS的队列中排队。 |

| tryAcquire()/tryAcquire(int permits) | 获取许可证。获取许可失败,直接返回false。 |

| tryAcquire(long timeout, TimeUnit unit)/ tryAcquire(int permits, long timeout, TimeUnit unit) | 超时等待获取许可证。 |

| release() | 归还许可证。 |

| intavailablePermits() | 返回此信号量中当前可用的许可证数。 |

| intgetQueueLength() | 返回正在等待获取许可证的线程数。 |

| booleanhasQueuedThreads() | 是否有线程正在等待获取许可证。 |

| void reducePermits(int reduction) | 减少reduction个许可证,是个protected方法。 |

| Collection getQueuedThreads() | 返回所有等待获取许可证的线程集合,是个protected方法。 |

使用示例:

public class SemaphoreTest {

private static final int THREAD_COUNT = 50;

public static void main(String[] args) throws InterruptedException {

// 创建一个具有固定线程数量的线程池对象

ExecutorService threadPool = Executors.newFixedThreadPool(THREAD_COUNT);

// 一次只能允许执行的线程数量

final Semaphore semaphore = new Semaphore(10);

for (int i = 0; i < THREAD_COUNT; i++) {

final int threadNum = i;

threadPool.execute(() -> {

try {

semaphore.acquire();// 获取1个许可,所以可运行线程数量为10/1=10

test(threadNum);

semaphore.release();// 释放1个许可,所以可运行线程数量为10/1=10

} catch (InterruptedException e) {

e.printStackTrace();

}

});

}

threadPool.shutdown();

}

public static void test(int threadNum) throws InterruptedException {

Thread.sleep(1000);// 模拟请求的耗时操作

System.out.println("threadNum:" + threadNum);

Thread.sleep(1000);// 模拟请求的耗时操作

}

}

在代码中,虽然有50个线程在执行,但是只允许10个并发执行。Semaphore的构造方法Semaphore(int permits)接受一个整型的数字,表示可用的许可证数量。Semaphore(10)表示允许10个线程获取许可证,也就是最大并发数是10。Semaphore的用法也很简单,首先线程使用Semaphore的acquire()方法获取一个许可证,使用完之后调用release()方法归还许可证。

除了 acquire方法之外,另一个比较常用的与之对应的方法是tryAcquire方法,该方法如果获取不到许可就立即返回 false。

4 CountDownLatch (倒计时器)

4.1 概述

在日常开发中经常会遇到需要在主线程中开启多个线程去并行执行任务,并且主线程需要等待所有子线程执行完毕后再进行汇总的场景。jdk 1.5之前一般都使用线程的join()方法来实现这一点,但是join方法不够灵活,难以满足不同场景的需要,所以jdk 1.5之后concurrent包提供了CountDownLatch这个类。

CountDownLatch是一种同步辅助工具,它允许一个或多个线程等待其他线程完成操作。

CountDownLatch是通过一个计数器来实现的,计数器的初始化值为线程的数量。每当一个线程完成了自己的任务后,计数器的值就相应得减1。当计数器到达0时,表示所有的线程都已完成任务,然后在闭锁上等待的线程就可以恢复执行任务。

CountDownLatch的方法:

| 方法 | 描述 |

|---|---|

| await() | 调用该方法的线程等到构造方法传入的 N 减到 0 的时候,才能继续往下执行。 |

| await(long timeout, TimeUnit unit) | 调用该方法的线程等到指定的 timeout 时间后,不管 N 是否减至为 0,都会继续往下执行。 |

| countDown() | 使 CountDownLatch 初始值 N 减 1。 |

| getCount() | 获取当前 CountDownLatch 维护的值,也就是AQS的state的值。 |

CountDownLatch的实现原理,可以查看 【JUC】JDK1.8源码分析之CountDownLatch(五)一文。

根据源码分析可知,CountDownLatch是AQS中共享锁的一种实现。AbstractQueuedSynchronizer中维护了一个volatile类型的整数state,volatile可以保证多线程环境下该变量的修改对每个线程都可见,并且由于该属性为整型,因而对该变量的修改也是原子的。

CountDownLatch默认构造 AQS 的 state 值为 count。创建一个CountDownLatch对象时,所传入的整数N就会赋值给state属性。

当调用countDown()方法时,其实是调用了tryReleaseShared方法以CAS的操作来对state减1;而调用await()方法时,当前线程就会判断state属性是否为0。如果为0,阻塞线程被唤醒继续往下执行;如果不为0,则使当前线程放入阻塞队列Park,直至最后一个线程调用了countDown()方法使得state == 0,再唤醒在await()方法中等待的线程。

特别注意的是:

CountDownLatch 是一次性的,计数器的值只能在构造方法中初始化一次,之后没有任何机制再次对其设置值,当 CountDownLatch 使用完毕后,它不能再次被使用。如果需要能重置计数,可以使用CyclicBarrier。

4.2 应用场景

CountDownLatch主要应用场景:

- 实现最大的并行性:同时启动多个线程,实现最大程度的并行性。例如110跨栏比赛中,所有运动员准备好起跑姿势,进入到预备状态,等待裁判一声枪响。裁判开了枪,所有运动员才可以开跑。

- 开始执行前等待N个线程完成各自任务:例如一群学生在教室考试,学生们都完成了作答,老师才可以进行收卷操作。

案例:

public class CountDownLatchTest {

private static final int THREAD_COUNT = 30;

public static void main(String[] args) throws InterruptedException {

ExecutorService threadPool = Executors.newFixedThreadPool(10);

final CountDownLatch countDownLatch = new CountDownLatch(THREAD_COUNT);

for (int i = 0; i < THREAD_COUNT; i++) {

final int threadNum = i;

threadPool.execute(() -> {

try {

Thread.sleep(1000);// 模拟请求的耗时操作

System.out.println("子线程:" + threadNum);

Thread.sleep(1000);// 模拟请求的耗时操作

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

countDownLatch.countDown();// 表示一个请求已经被完成

}

});

}

System.out.println("主线程启动...");

countDownLatch.await();

threadPool.shutdown();

System.out.println("子线程执行完毕...");

System.out.println("主线程执行完毕...");

}

}

上面的代码中,我们定义了请求的数量为30,当这 30 个请求被处理完成之后,才会打印子线程执行完毕。

主线程在启动其他线程后调用 CountDownLatch.await() 方法进入阻塞状态,直到其他线程完成各自的任务才被唤醒。

开启的30个线程必须引用闭锁对象,因为他们需要通知 CountDownLatch 对象,他们已经完成了各自的任务。这种通知机制是通过 CountDownLatch.countDown()方法来完成的;每调用一次这个方法,在构造函数中初始化的 count 值就减 1。所以当30个线程都调用了这个方法后,count 的值才等于0,然后主线程就能通过 await()方法,继续执行自己的任务。

5 CyclicBarrier(循环栅栏)

5.1 概述

CyclicBarrier的字面意思是可循环使用(Cyclic)的屏障(Barrier)。它要做的事情是,让一组线程到达一个屏障(也可以叫同步点)时被阻塞,直到最后一个线程到达屏障时,屏障才会开门,所有被屏障拦截的线程才会继续运行。CyclicBarrier 的功能和应用场景与CountDownLatch都非常类似。

CyclicBarrier常用方法:

| 常用方法 | 描述 |

|---|---|

| await() | 在所有线程都已经在此 barrier上并调用 await 方法之前,将一直等待。 |

| await(long timeout, TimeUnit unit) | 所有线程都已经在此屏障上调用 await 方法之前将一直等待,或者超出了指定的等待时间。 |

| getNumberWaiting() | 返回当前在屏障处等待的线程数目。 |

| getParties() | 返回要求启动此 barrier 的线程数目。 |

| isBroken() | 查询此屏障是否处于损坏状态。 |

| reset() | 将屏障重置为其初始状态。 |

5.2 源码分析

构造函数:

// 创建一个新的 CyclicBarrier,它将在给定数量的参与者(线程)处于等待状态时启动,但它不会在启动 barrier 时执行预定义的操作。

public CyclicBarrier(int parties) {

this(parties, null);

}

// 创建一个新的 CyclicBarrier,它将在给定数量的参与者(线程)处于等待状态时启动,并在启动 barrier 时执行给定的屏障操作。

// 该操作由最后一个进入 barrier 的线程执行。

public CyclicBarrier(int parties, Runnable barrierAction) {

if (parties <= 0) throw new IllegalArgumentException();

this.parties = parties;

this.count = parties;

this.barrierCommand = barrierAction;

}

其中,parties 就表示屏障拦截的线程数量。

CyclicBarrier 的最重要的方法就是 await 方法,await() 方法就像树立起一个栅栏的行为一样,将线程挡住了,当拦住的线程数量达到 parties 的值时,栅栏才会打开,线程才得以通过执行。

public int await() throws InterruptedException, BrokenBarrierException {

try {

return dowait(false, 0L);

} catch (TimeoutException toe) {

throw new Error(toe);

}

}

当调用 await() 方法时,实际上调用的是dowait(false, 0L)方法。查看dowait(boolean timed, long nanos):

// 当线程数量或者请求数量达到 count 时 await 之后的方法才会被执行。

private int count;

private int dowait(boolean timed, long nanos)

throws InterruptedException, BrokenBarrierException,

TimeoutException {

final ReentrantLock lock = this.lock;

// 获取”独占锁“

lock.lock();

try {

// 保存“当前的generation”

final Generation g = generation;

// 如果当前代损坏,抛出异常

if (g.broken)

throw new BrokenBarrierException();

// 如果线程中断,抛出异常

if (Thread.interrupted()) {

// 将损坏状态设置为 true,并唤醒所有阻塞在此栅栏上的线程

breakBarrier();

throw new InterruptedException();

}

// 将“count计数器”-1

int index = --count;

// 当 count== 0,说明最后一个线程已经到达栅栏

if (index == 0) {

boolean ranAction = false;

try {

final Runnable command = barrierCommand;

// 执行栅栏任务

if (command != null)

command.run();

ranAction = true;

// 将 count 重置为 parties 属性的初始化值

// 唤醒之前等待的线程,并更新generation。

nextGeneration();

// 结束,等价于return index

return 0;

} finally {

if (!ranAction)

breakBarrier();

}

}

// 当前线程一直阻塞,直到“有parties个线程到达barrier” 或 “当前线程被中断” 或 “超时”这3者条件之一发生

// 当前线程才继续执行。

for (;;) {

try {

// 如果没有时间限制,则直接等待,直到被唤醒。

if (!timed)

trip.await();

// 如果有时间限制,则等待指定时间再唤醒(超时等待)。

else if (nanos > 0L)

nanos = trip.awaitNanos(nanos);

} catch (InterruptedException ie) {

// 当前代没有损坏

if (g == generation && ! g.broken) {

// 让栅栏失效

breakBarrier();

throw ie;

} else {

// 上面条件不满足,说明这个线程不是这代的。

// 就不会影响当前这代栅栏执行逻辑。中断。

Thread.currentThread().interrupt();

}

}

// 如果“当前generation已经损坏”,则抛出异常。

if (g.broken)

throw new BrokenBarrierException();

// 如果“generation已经换代”,则返回index。

if (g != generation)

return index;

// 如果是“超时等待”,并且时间已到,则通过breakBarrier()终止CyclicBarrier

// 唤醒CyclicBarrier中所有等待线程。

if (timed && nanos <= 0L) {

breakBarrier();

throw new TimeoutException();

}

}

} finally {

// 释放“独占锁(lock)”

lock.unlock();

}

}

generation是CyclicBarrier的一个成员变量:

/**

* Generation一代的意思。

* CyclicBarrier是可以循环使用的,用它来标志本代和下一代。

* broken:当前代是否损坏的标志。标志有线程发生了中断,或者异常,就是任务没有完成。

*/

private static class Generation {

boolean broken = false;

}

// 实现独占锁

private final ReentrantLock lock = new ReentrantLock();

// 实现多个线程之间相互等待通知,就是满足某些条件之后,线程才能执行,否则就等待

private final Condition trip = lock.newCondition();

// 初始化时屏障数量

private final int parties;

// 当条件满足(即屏障数量为0)之后,会回调这个Runnable

private final Runnable barrierCommand;

//当前代

private Generation generation = new Generation();

// 剩余的屏障数量count

private int count;

在CyclicBarrier中,同一批的线程属于同一代,即同一个generation;CyclicBarrier中通过generation对象,记录属于哪一代。 当有parties个线程到达barrier,generation就会被更新换代。

总结:

CyclicBarrier内部通过一个 count 变量作为计数器,cout 的初始值为 parties 属性的初始化值,每当一个线程到了栅栏,那么就将计数器减1。如果 count 值为 0 了,表示这是这一代最后一个线程到达栅栏,就会将代更新并重置计数器,并唤醒所有之前等待在栅栏上的线程。- 如果在等待的过程中,线程中断都也会抛出BrokenBarrierException异常,并且这个异常会传播到其他所有的线程,CyclicBarrier会被损坏。

- 如果超出指定的等待时间,当前线程会抛出 TimeoutException 异常,其他线程会抛出BrokenBarrierException异常,CyclicBarrier会被损坏。

5.3 应用场景

CyclicBarrier 可以用于多线程计算数据,最后合并计算结果的应用场景。比如我们用一个 Excel 保存了用户所有银行流水,每个 Sheet 保存一个帐户近一年的每笔银行流水,现在需要统计用户的日均银行流水,先用多线程处理每个 sheet 里的银行流水,都执行完之后,得到每个 sheet 的日均银行流水,最后,再用 barrierAction 用这些线程的计算结果,计算出整个 Excel 的日均银行流水。

示例 1:

public class CyclicBarrierTest1 {

private static final int THREAD_COUNT = 30;

// 需要同步的线程数量

private static final CyclicBarrier cyclicBarrier = new CyclicBarrier(5);

public static void main(String[] args) throws InterruptedException {

// 创建线程池

ExecutorService threadPool = Executors.newFixedThreadPool(10);

for (int i = 0; i < THREAD_COUNT; i++) {

final int threadNum = i;

Thread.sleep(1000);

threadPool.execute(() -> {

System.out.println("childThread:" + threadNum + " is ready");

try {

// 等待60秒,保证子线程完全执行结束

cyclicBarrier.await(60, TimeUnit.SECONDS);

} catch (InterruptedException e) {

e.printStackTrace();

} catch (BrokenBarrierException e) {

e.printStackTrace();

} catch (TimeoutException e) {

e.printStackTrace();

}

System.out.println("childThread:" + threadNum + " is finish");

});

}

threadPool.shutdown();

}

}

运行结果如下:

childThread:0 is ready

childThread:1 is ready

childThread:2 is ready

childThread:3 is ready

childThread:4 is ready

childThread:4 is finish

childThread:0 is finish

childThread:1 is finish

childThread:3 is finish

childThread:2 is finish

childThread:5 is ready

childThread:6 is ready

childThread:7 is ready

childThread:8 is ready

childThread:9 is ready

childThread:9 is finish

childThread:8 is finish

... ...

可以看到当线程数量也就是请求数量达定义的 5 个的时候, await方法之后的方法才被执行。

另外,CyclicBarrier 还提供一个更高级的构造函数CyclicBarrier(int parties, Runnable barrierAction),用于在线程到达屏障时,优先执行barrierAction,方便处理更复杂的业务场景。示例代码如下:

public class CyclicBarrierTest2 {

private static final int THREAD_COUNT = 30;

// 需要同步的线程数量

private static final CyclicBarrier cyclicBarrier = new CyclicBarrier(5, () -> {

System.out.println("------优先执行------");

});

public static void main(String[] args) throws InterruptedException {

// 创建线程池

ExecutorService threadPool = Executors.newFixedThreadPool(10);

for (int i = 0; i < THREAD_COUNT; i++) {

final int threadNum = i;

Thread.sleep(1000);

threadPool.execute(() -> {

System.out.println("childThread:" + threadNum + " is ready");

try {

// 等待60秒,保证子线程完全执行结束

cyclicBarrier.await(60, TimeUnit.SECONDS);

} catch (InterruptedException e) {

e.printStackTrace();

} catch (BrokenBarrierException e) {

e.printStackTrace();

} catch (TimeoutException e) {

e.printStackTrace();

}

System.out.println("childThread:" + threadNum + " is finish");

});

}

threadPool.shutdown();

}

}

运行结果如下:

childThread:0 is ready

childThread:1 is ready

childThread:2 is ready

childThread:3 is ready

childThread:4 is ready

------优先执行------

childThread:4 is finish

childThread:0 is finish

childThread:1 is finish

childThread:3 is finish

childThread:2 is finish

childThread:5 is ready

childThread:6 is ready

childThread:7 is ready

childThread:8 is ready

childThread:9 is ready

------优先执行------

childThread:9 is finish

childThread:6 is finish

... ...

5.4 CyclicBarrier和CountDownLatch的区别

- CountDownLatch的计数器只能使用一次。而CyclicBarrier的计数器可以使用reset()方法重置,可多次使用。

- 侧重点不同。CountDownLatch多用于某一个线程等待若干个其他线程执行完任务之后,它才执行;而CyclicBarrier一般用于多个线程互相等待至一个同步点,然后这些线程再继续一起执行。

- CyclicBarrier还提供其他有用的方法,比如getNumberWaiting方法可以获得Cyclic-Barrier阻塞的线程数量;isBroken()方法用来了解阻塞的线程是否被中断。

十三、ReentrantLock 、 ReentrantReadWriteLock 、StampedLock(JDK8)

JDK8的一种新的读写锁StampedLock

JDK8新增一种新的读写锁StampedLock。一个最重要的功能改进就是读写锁中解决写线程饥饿的问题。

StampedLock与ReentrantReadWriteLock

以StampedLock与ReentrantReadWriteLock两者比较为线索介绍StampedLock锁。关于ReentrantReadWriteLock锁参考文档ReentrantReadWriteLock源码解析。

StampedLock不基于AQS实现

之前包括ReentrantReadWriteLock,ReentrantLock和信号量等同步工具,都是基于AQS同步框架实现的。而在StampedLock中摒弃了AQS框架,为StampedLock实现提供了更多的灵活性。

StampedLock增加乐观读锁机制

先获取记录下当前锁的版本号stamp,执行读取操作后,要验证这个版本号是否改变,如果没有改变继续执行接下来的逻辑。乐观读锁机制基于在系统中大多数时间线程并发竞争不严重,绝大多数读操作都可以在没有竞争的情况下完成的论断。

//乐观读锁

stamp = lock.tryOptimisticRead();

//do some reading

if (lock.validate(stamp)) {

//do somethinng

}

实际中,乐观读的实现是通过判断state的高25位是否有变化来实现的,获取乐观读锁也仅仅是返回当前锁的版本号

public long tryOptimisticRead() {

long s;

return (((s = state) & WBIT) == 0L) ? (s & SBITS) : 0L;

}

StampedLock锁的状态和版本号

基于AQS实现实现的ReentrantReadWriteLock,高16位存储读锁被获取的次数,低16位存储写锁被获取的次数。 而摒弃了AQS的StampedLock,自身维护了一个状态变量state。

private transient volatile long state;

StampedLock的状态变量state被分成3段:

- 高24位存储版本号,只有写锁增加其版本号,而读锁不会增加其版本号;

- 低7位存储读锁被获取的次数;

- 第8位存储写锁被获取的次数,因为只有一位用于表示写锁,所以StampedLock不是可重入锁。

关于状态变量state操作的变量设置:

private static final int LG_READERS = 7; //读线程的个数占有低7位

// Values for lock state and stamp operations

private static final long RUNIT = 1L; //读线程个数每次增加的单位

private static final long WBIT = 1L << LG_READERS;//写线程个数所在的位置 1000 0000

private static final long RBITS = WBIT - 1L;//读线程个数的掩码 111 1111

private static final long RFULL = RBITS - 1L;//最大读线程个数

private static final long ABITS = RBITS | WBIT;//读线程个数和写线程个数的掩码 1111 1111

// Initial value for lock state; avoid failure value zero

//state的初始值。 1 0000 0000,也就是高24位最后一位为1,版本号初始值为1 0000 0000。锁获取失败返回版本号0。

private static final long ORIGIN = WBIT << 1;

StampedLock自旋

如下代码片段,可以看到StampedLock锁获取时存在大量自旋逻辑(for循环)。自旋是一种锁优化技术,在并发程序中大多数的锁持有时间很短暂,通过自旋可以避免线程被阻塞和唤醒产生的开销。 自旋技术对于系统中持有锁时间短暂的任务比较高效,但是对于持有锁时间长的任务是对CPU的浪费。

private long acquireWrite(boolean interruptible, long deadline) {

for (int spins = -1;;) { // spin while enqueuing

....省略代码逻辑....

}

for (int spins = -1;;) {

....省略代码逻辑....

for (int k = spins;;) { // spin at head

....省略代码逻辑....

}

private long acquireRead(boolean interruptible, long deadline) {

for (int spins = -1;;) {

....省略代码逻辑....

for (long m, s, ns;;) {

....省略代码逻辑....

}

....省略代码逻辑....

for (;;) {

....省略代码逻辑....

for (int spins = -1;;) {

for (int k = spins;;) { // spin at head

....省略代码逻辑....

}

StampedLock的CLH队列

StampedLock的CLH队列是一个经过改良的队列,在ReentrantReadWriteLock的等待队列中每个线程节点是依次排队,然后责任链设计模式依次唤醒,这样就可能导致读线程全部唤醒,而写线程处于饥饿状态。StampedLock的等待队列,连续的读线程只有首个节点存储在队列中,其它的节点存储在首个节点的cowait队列中。

StampedLock唤醒读锁是一次性唤醒连续的读锁节点。

类WNode是StampedLock等待队列的节点,cowait存放连续的读线程。

static final class WNode {

volatile WNode prev;

volatile WNode next;

//cowait存放连续的读线程

volatile WNode cowait; // list of linked readers

volatile Thread thread; //non-null while possibly parked

volatile int status; // 0, WAITING, or CANCELLED

final int mode; // RMODE or WMODE

WNode(int m, WNode p) { mode = m; prev = p; }

}

如果两个读节点之间有一个写节点,那么这两个读节点就不是连续的,会分别排队。正是因为这样的机制,会按照到来顺序让先到的写线程先于它后面的读线程执行。

StampedLock只有非公平模式,线程到来就会尝试获取锁。

十四、CAS 了解么?原理?

1、什么是CAS?

CAS:Compare and Swap,即比较再交换。

jdk5增加了并发包java.util.concurrent.*,其下面的类使用CAS算法实现了区别于synchronouse同步锁的一种乐观锁。JDK 5之前Java语言是靠synchronized关键字保证同步的,这是一种独占锁,也是是悲观锁。

2、CAS算法理解

对CAS的理解,CAS是一种无锁算法,CAS有3个操作数,内存值V,旧的预期值A,要修改的新值B。当且仅当预期值A和内存值V相同时,将内存值V修改为B,否则什么都不做。

CAS比较与交换的伪代码可以表示为:

do{

备份旧数据;

基于旧数据构造新数据;

}while(!CAS( 内存地址,备份的旧数据,新数据 ))

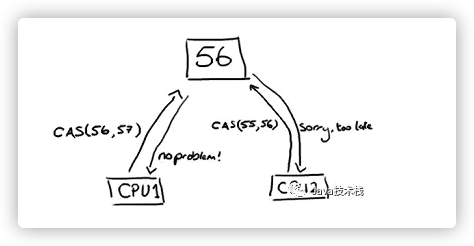

注:t1,t2线程是同时更新同一变量56的值

因为t1和t2线程都同时去访问同一变量56,所以他们会把主内存的值完全拷贝一份到自己的工作内存空间,所以t1和t2线程的预期值都为56。

假设t1在与t2线程竞争中线程t1能去更新变量的值,而其他线程都失败。(失败的线程并不会被挂起,而是被告知这次竞争中失败,并可以再次发起尝试)。t1线程去更新变量值改为57,然后写到内存中。此时对于t2来说,内存值变为了57,与预期值56不一致,就操作失败了(想改的值不再是原来的值)。

(上图通俗的解释是:CPU去更新一个值,但如果想改的值不再是原来的值,操作就失败,因为很明显,有其它操作先改变了这个值。)

就是指当两者进行比较时,如果相等,则证明共享数据没有被修改,替换成新值,然后继续往下运行;如果不相等,说明共享数据已经被修改,放弃已经所做的操作,然后重新执行刚才的操作。容易看出 CAS 操作是基于共享数据不会被修改的假设,采用了类似于数据库的commit-retry 的模式。当同步冲突出现的机会很少时,这种假设能带来较大的性能提升。

3、CAS开销

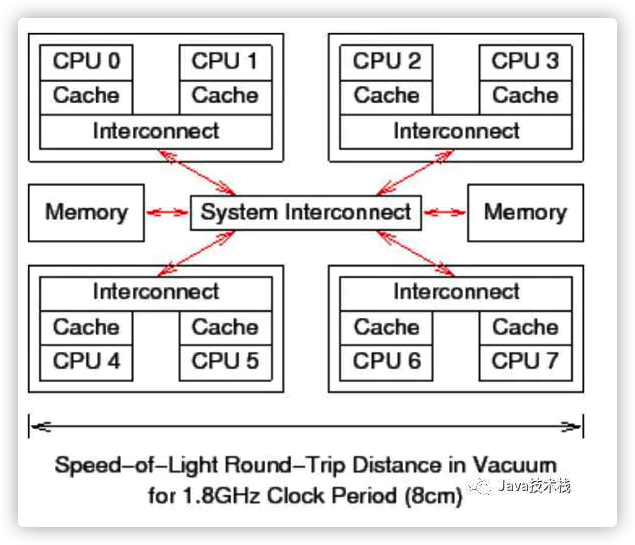

前面说过了,CAS(比较并交换)是CPU指令级的操作,只有一步原子操作,所以非常快。而且CAS避免了请求操作系统来裁定锁的问题,不用麻烦操作系统,直接在CPU内部就搞定了。但CAS就没有开销了吗?不!有cache miss的情况。这个问题比较复杂,首先需要了解CPU的硬件体系结构:

上图可以看到一个8核CPU计算机系统,每个CPU有cache(CPU内部的高速缓存,寄存器),管芯内还带有一个互联模块,使管芯内的两个核可以互相通信。在图中央的系统互联模块可以让四个管芯相互通信,并且将管芯与主存连接起来。数据以“缓存线”为单位在系统中传输,“缓存线”对应于内存中一个 2 的幂大小的字节块,大小通常为 32 到 256 字节之间。当 CPU 从内存中读取一个变量到它的寄存器中时,必须首先将包含了该变量的缓存线读取到 CPU 高速缓存。同样地,CPU 将寄存器中的一个值存储到内存时,不仅必须将包含了该值的缓存线读到 CPU 高速缓存,还必须确保没有其他 CPU 拥有该缓存线的拷贝。

比如,如果 CPU0 在对一个变量执行“比较并交换”(CAS)操作,而该变量所在的缓存线在 CPU7 的高速缓存中,就会发生以下经过简化的事件序列:

CPU0 检查本地高速缓存,没有找到缓存线。

请求被转发到 CPU0 和 CPU1 的互联模块,检查 CPU1 的本地高速缓存,没有找到缓存线。

请求被转发到系统互联模块,检查其他三个管芯,得知缓存线被 CPU6和 CPU7 所在的管芯持有。

请求被转发到 CPU6 和 CPU7 的互联模块,检查这两个 CPU 的高速缓存,在 CPU7 的高速缓存中找到缓存线。

CPU7 将缓存线发送给所属的互联模块,并且刷新自己高速缓存中的缓存线。

CPU6 和 CPU7 的互联模块将缓存线发送给系统互联模块。

系统互联模块将缓存线发送给 CPU0 和 CPU1 的互联模块。

CPU0 和 CPU1 的互联模块将缓存线发送给 CPU0 的高速缓存。

CPU0 现在可以对高速缓存中的变量执行 CAS 操作了

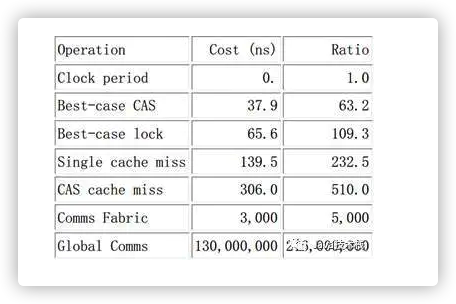

以上是刷新不同CPU缓存的开销。最好情况下的 CAS 操作消耗大概 40 纳秒,超过 60 个时钟周期。这里的“最好情况”是指对某一个变量执行 CAS 操作的 CPU 正好是最后一个操作该变量的CPU,所以对应的缓存线已经在 CPU 的高速缓存中了,类似地,最好情况下的锁操作(一个“round trip 对”包括获取锁和随后的释放锁)消耗超过 60 纳秒,超过 100 个时钟周期。这里的“最好情况”意味着用于表示锁的数据结构已经在获取和释放锁的 CPU 所属的高速缓存中了。锁操作比 CAS 操作更加耗时,是因深入理解并行编程

为锁操作的数据结构中需要两个原子操作。缓存未命中消耗大概 140 纳秒,超过 200 个时钟周期。需要在存储新值时查询变量的旧值的 CAS 操作,消耗大概 300 纳秒,超过 500 个时钟周期。想想这个,在执行一次 CAS 操作的时间里,CPU 可以执行 500 条普通指令。这表明了细粒度锁的局限性。

以下是cache miss cas 和lock的性能对比:

4、CAS算法在JDK中的应用

在原子类变量中,如java.util.concurrent.atomic中的AtomicXXX,都使用了这些底层的JVM支持为数字类型的引用类型提供一种高效的CAS操作,而在java.util.concurrent中的大多数类在实现时都直接或间接的使用了这些原子变量类。

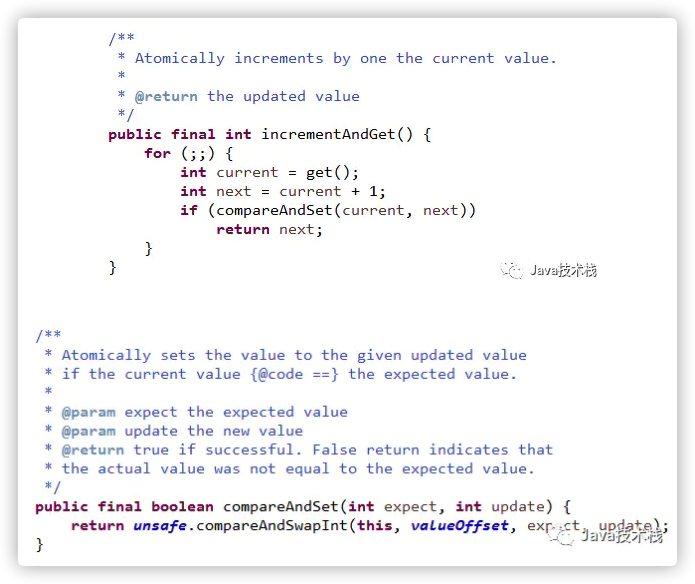

Java 1.7中AtomicInteger.incrementAndGet()的实现源码为:

由此可见,AtomicInteger.incrementAndGet的实现用了乐观锁技术,调用了类sun.misc.Unsafe库里面的 CAS算法,用CPU指令来实现无锁自增。所以,AtomicInteger.incrementAndGet的自增比用synchronized的锁效率倍增。

十五、Atomic 原子类

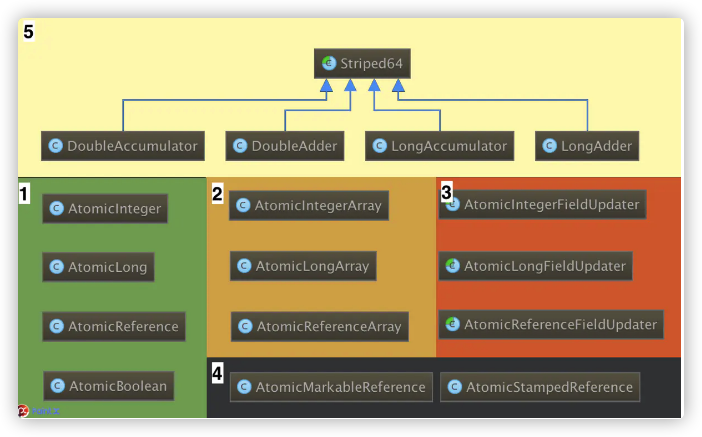

Atomic概览

整个atomic包包含了17个类,如下图所示:根据其功能及其实现原理,可将其分为五个部分。本文主要针对图中序号1都部分进行源码阅读和分析。

核心对象——Unsafe

整个atomic都是基于Unsafe实现的,Unsafe通过通过单例模式来提供实例对象,这里我们主要关注它提供的几个方法:

# 清单1 sun.misc.Unsafe.class

public final native boolean compareAndSwapInt(Object var1, long var2,

int var4, int var5); // 核心方法CAS

// 参数释义:var1为类对象,参数var2为Field的偏移量,var4为旧值,var5为更新后的值

//(对象和偏移量构成唯一的内存地址,如果对源码JVM有兴趣,可下载源码参考,非本文范畴,不赘述)。

// 计算偏移量

public native long staticFieldOffset(Field var1);

public native long objectFieldOffset(Field var1);

Unsafe提供的大多是native方法,compareAndSwapInt()通过原子的方式将期望值和内存中的值进行对比,如果两者相等,则执行更新操作。

staticFieldOffset()和objectFieldOffset()两方法分别提供两静态、非静态域的偏移量计算方法。

注意:之所以命名为Unsafe,因为该对于大部分Java开发者来说是不安全的,它像C一样,拥有操作指针、分配和回收内存的能力,由该对象申请的内存是无法被JVM回收的,因此轻易别用。当然,如果对并发有非常浓厚的兴趣,就要好好研究下它,许多高性能的框架都使用它作为底层实现,如Netty、Kafka。

AtomicInteger的基本实现

接着再来看AtomicInteger的源码:

# 清单2 AtomicInteger

private static final Unsafe unsafe = Unsafe.getUnsafe(); // 获取单例对象

private static final long valueOffset; // 偏移量

static {

try{

valueOffset = unsafe.objectFieldOffset

(AtomicInteger.class.getDeclaredField("value")) // 计算偏移量

} catch(Exception ex){ throw new Error(ex);}

}

private volatile int value; // 使用volatile修饰,保证可见性

私有的静态域Unsafe对象和偏移量都是final修饰的,在静态代码块中,通过Unsafe实例计算出域value的偏移地址。 value使用volatile来修饰,保证了其可见性。

# 清单3 getAndSetInt的实现

public final int getAndSetInt(Object var1, long var2, int var4) {

int var5;

do {

var5 = this.getIntVolatile(var1, var2); // 原子获取变量的值

} while(!this.compareAndSwapInt(var1, var2, var5, var4));

// CAS操作,失败重试

return var5;

}

通过方法名可知清单3中的方法getAndSetInt()为获取旧值并赋予新值的操作,通过CAS失败重试的机制来实现原子操作,这就是乐观锁的思想,也是整个并发包的核心思想。

扩展-灵活的函数式编程

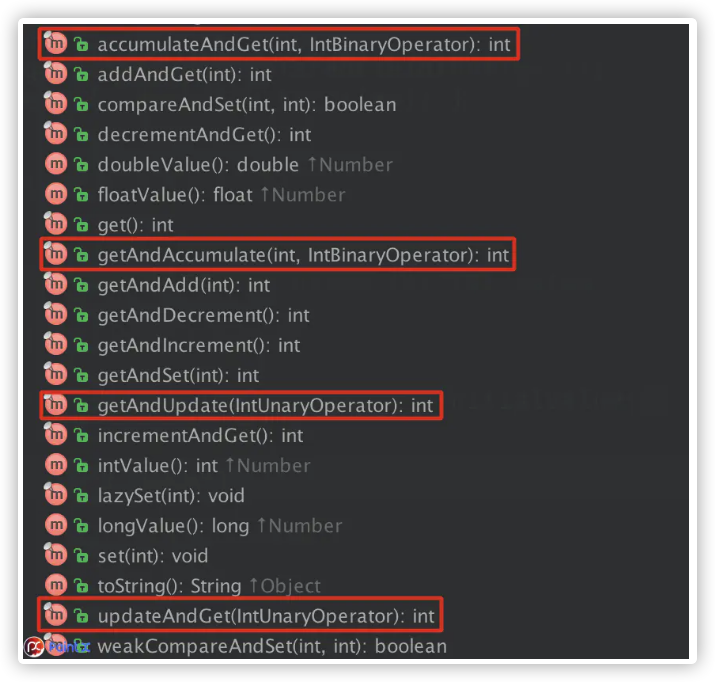

AtomicInteger方法

AtomicInteger的方法中,除了简单的加、减、更新和获取的原子操作外,在JDK1.8中增加了4个方法,即图上标红的方法。通过函数式编程,可以灵活的实现更加复杂的原子操作。

# 清单5 IntUnaryOperator接口

int applyAsInt(int operand);

default IntUnaryOperator compose(IntUnaryOperator before) {

Objects.requireNonNull(before);

return (int v) -> applyAsInt(before.applyAsInt(v));

}

default IntUnaryOperator andThen(IntUnaryOperator after) {

Objects.requireNonNull(after);

return (int t) -> after.applyAsInt(applyAsInt(t));

}

该接口定义了一个待实现方法和两个默认方法,通过compose和andThen即可实现多个IntUnaryOperator的组合调用。在AtomicInteger中做如下调用:

# 清单6 AtomicInteger代码片段

public final int getAndUpdate(IntUnaryOperator updateFunction) {

int prev, next;

do {

prev = get(); // 获取当前值

next = updateFunction.applyAsInt(prev); // 函数调用计算

} while (!compareAndSet(prev, next)); // CAS更新操作

return prev;

}

如同代码清单7,通过函数式编程,可以轻易地完成复杂计算的原子操作。除了IntUnaryOperator接口,还有一个IntBinaryOperator接口,该接口支持额外增加的参数参与计算,两者有相似之处

# 清单7 IntUnaryOperatorTest

public static void main(String[] args) {

IntOperatorAdd add = new IntOperatorAdd();

IntOperatorMul mul = new IntOperatorMul();

int result = new AtomicInteger(3).updateAndGet(add); // 结果为6 -> 3+3

int result2 = new AtomicInteger(3).updateAndGet(mul); // 结果为9 -> 3*3

int result3 = new AtomicInteger(3).updateAndGet(add.andThen(mul));

// 结果为36 -> 3+3=6, 6*6=36

}

private static class IntOperatorAdd implements IntUnaryOperator {

@Override

public int applyAsInt(int operand) {

return operand + operand;

}

}

private static class IntOperatorMul implements IntUnaryOperator {

@Override

public int applyAsInt(int operand) {

return operand * operand;

}

}

其他原子操作类

除了AtomicInteger外,还有AtomicLong、AtomicReference以及AtomicBoolean三个原子包装类。其实现原理都是一致的,均可举一反三。

十六、并发容器:ConcurrentHashMap 、 CopyOnWriteArrayList 、 ConcurrentLinkedQueue BlockingQueue 、ConcurrentSkipListMap

前言

不考虑多线程并发的情况下,容器类一般使用ArrayList、HashMap等线程不安全的类,效率更高。在并发场景下,常会用到ConcurrentHashMap、ArrayBlockingQueue等线程安全的容器类,虽然牺牲了一些效率,但却得到了安全。

上面提到的线程安全容器都在java.util.concurrent包下,这个包下并发容器不少,今天全部翻出来鼓捣一下。

仅做简单介绍,后续再分别深入探索。

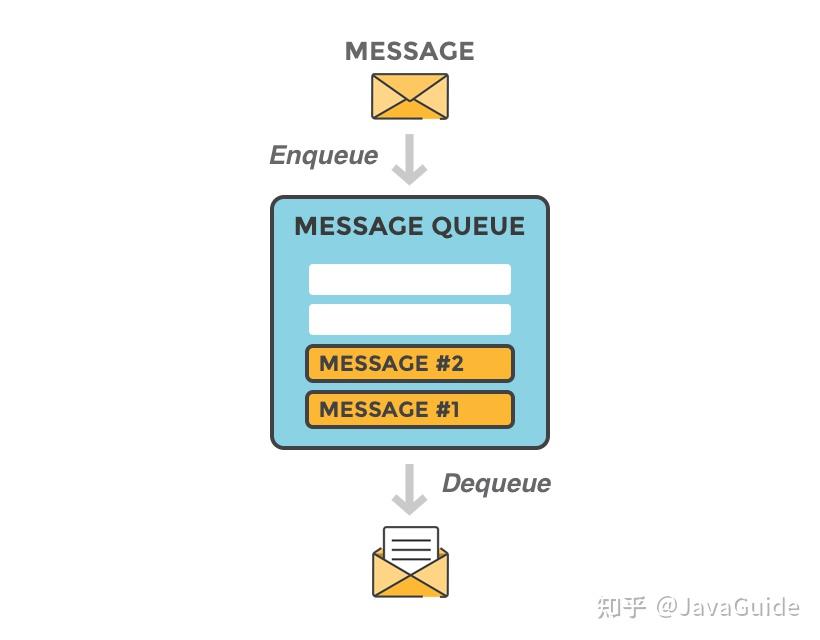

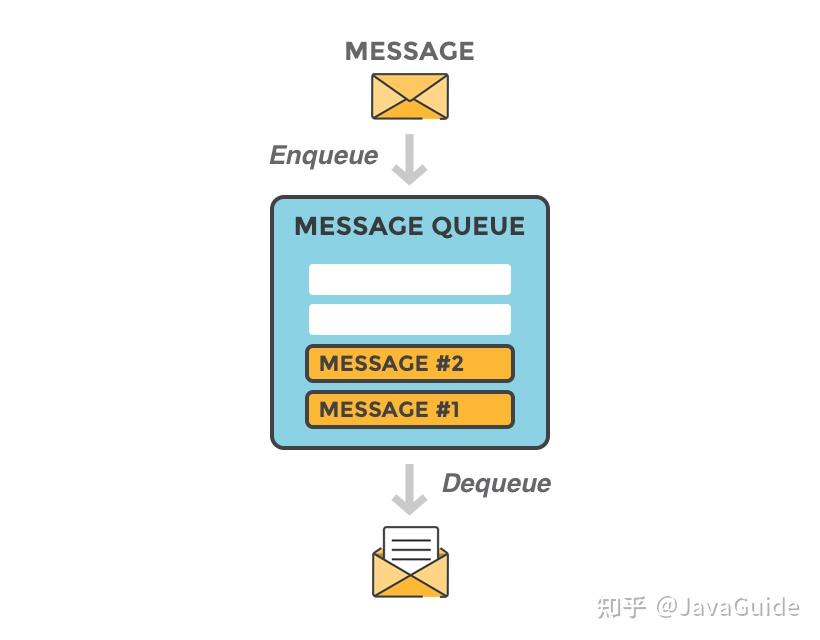

并发容器介绍

- ConcurrentHashMap:并发版HashMap

- CopyOnWriteArrayList:并发版ArrayList

- CopyOnWriteArraySet:并发Set

- ConcurrentLinkedQueue:并发队列(基于链表)

- ConcurrentLinkedDeque:并发队列(基于双向链表)

- ConcurrentSkipListMap:基于跳表的并发Map

- ConcurrentSkipListSet:基于跳表的并发Set

- ArrayBlockingQueue:阻塞队列(基于数组)

- LinkedBlockingQueue:阻塞队列(基于链表)

- LinkedBlockingDeque:阻塞队列(基于双向链表)

- PriorityBlockingQueue:线程安全的优先队列

- SynchronousQueue:读写成对的队列

- LinkedTransferQueue:基于链表的数据交换队列

- DelayQueue:延时队列

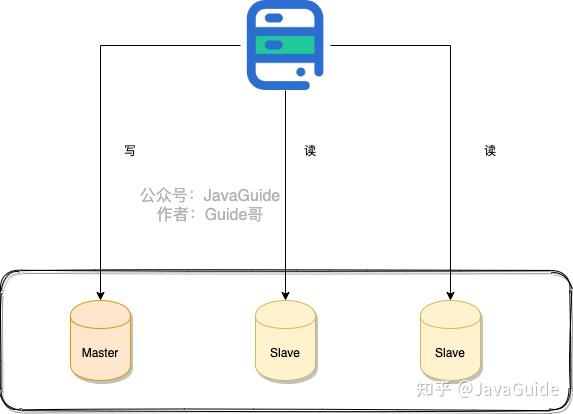

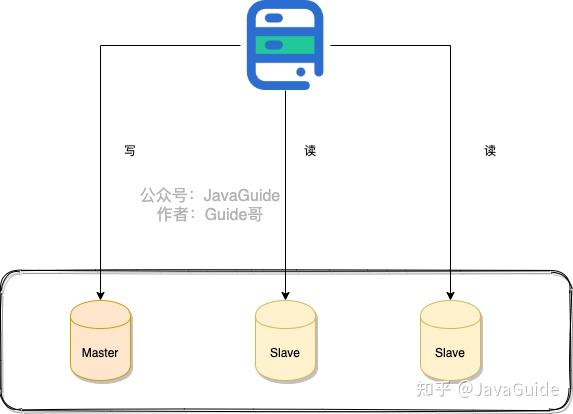

1.ConcurrentHashMap 并发版HashMap

最常见的并发容器之一,可以用作并发场景下的缓存。底层依然是哈希表,但在JAVA 8中有了不小的改变,而JAVA 7和JAVA 8都是用的比较多的版本,因此经常会将这两个版本的实现方式做一些比较(比如面试中)。

一个比较大的差异就是,JAVA 7中采用分段锁来减少锁的竞争,JAVA 8中放弃了分段锁,采用CAS(一种乐观锁),同时为了防止哈希冲突严重时退化成链表(冲突时会在该位置生成一个链表,哈希值相同的对象就链在一起),会在链表长度达到阈值(8)后转换成红黑树(比起链表,树的查询效率更稳定)。

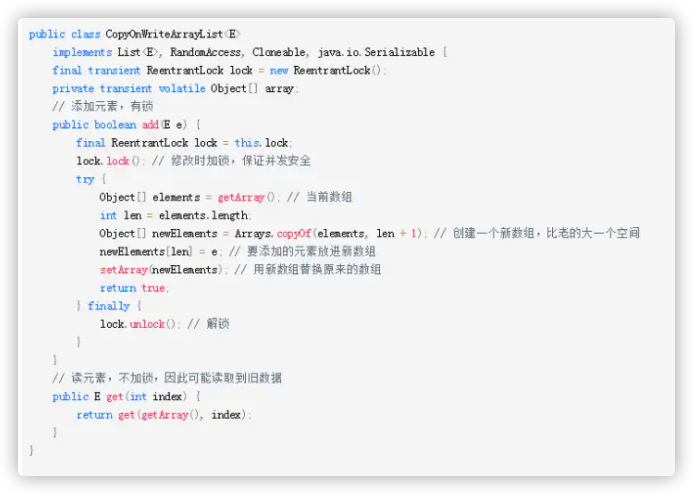

2.CopyOnWriteArrayList 并发版ArrayList

并发版ArrayList,底层结构也是数组,和ArrayList不同之处在于:当新增和删除元素时会创建一个新的数组,在新的数组中增加或者排除指定对象,最后用新增数组替换原来的数组。

适用场景:由于读操作不加锁,写(增、删、改)操作加锁,因此适用于读多写少的场景。

局限:由于读的时候不会加锁(读的效率高,就和普通ArrayList一样),读取的当前副本,因此可能读取到脏数据。如果介意,建议不用。

看看源码感受下:

3.CopyOnWriteArraySet 并发Set

基于CopyOnWriteArrayList实现(内含一个CopyOnWriteArrayList成员变量),也就是说底层是一个数组,意味着每次add都要遍历整个集合才能知道是否存在,不存在时需要插入(加锁)。

适用场景:在CopyOnWriteArrayList适用场景下加一个,集合别太大(全部遍历伤不起)。

4.ConcurrentLinkedQueue 并发队列(基于链表)

基于链表实现的并发队列,使用乐观锁(CAS)保证线程安全。因为数据结构是链表,所以理论上是没有队列大小限制的,也就是说添加数据一定能成功。

5.ConcurrentLinkedDeque 并发队列(基于双向链表)

基于双向链表实现的并发队列,可以分别对头尾进行操作,因此除了先进先出(FIFO),也可以先进后出(FILO),当然先进后出的话应该叫它栈了。

6.ConcurrentSkipListMap 基于跳表的并发Map

SkipList即跳表,跳表是一种空间换时间的数据结构,通过冗余数据,将链表一层一层索引,达到类似二分查找的效果

7.ConcurrentSkipListSet 基于跳表的并发Set

类似HashSet和HashMap的关系,ConcurrentSkipListSet里面就是一个ConcurrentSkipListMap,就不细说了。

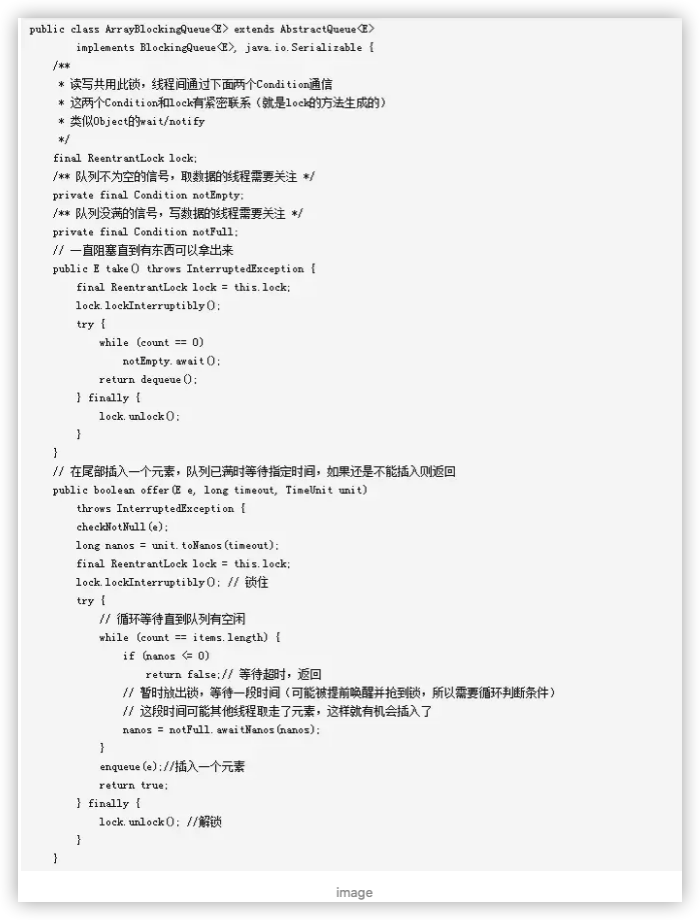

8.ArrayBlockingQueue 阻塞队列(基于数组)

基于数组实现的可阻塞队列,构造时必须制定数组大小,往里面放东西时如果数组满了便会阻塞直到有位置(也支持直接返回和超时等待),通过一个锁ReentrantLock保证线程安全。

乍一看会有点疑惑,读和写都是同一个锁,那要是空的时候正好一个读线程来了不会一直阻塞吗?

答案就在notEmpty、notFull里,这两个出自lock的小东西让锁有了类似synchronized + wait + notify的功能。传送门 → 终于搞懂了sleep/wait/notify/notifyAll

9.LinkedBlockingQueue 阻塞队列(基于链表)

基于链表实现的阻塞队列,想比与不阻塞的ConcurrentLinkedQueue,它多了一个容量限制,如果不设置默认为int最大值。

10.LinkedBlockingDeque 阻塞队列(基于双向链表)

类似LinkedBlockingQueue,但提供了双向链表特有的操作。

11.PriorityBlockingQueue 线程安全的优先队列

构造时可以传入一个比较器,可以看做放进去的元素会被排序,然后读取的时候按顺序消费。某些低优先级的元素可能长期无法被消费,因为不断有更高优先级的元素进来。

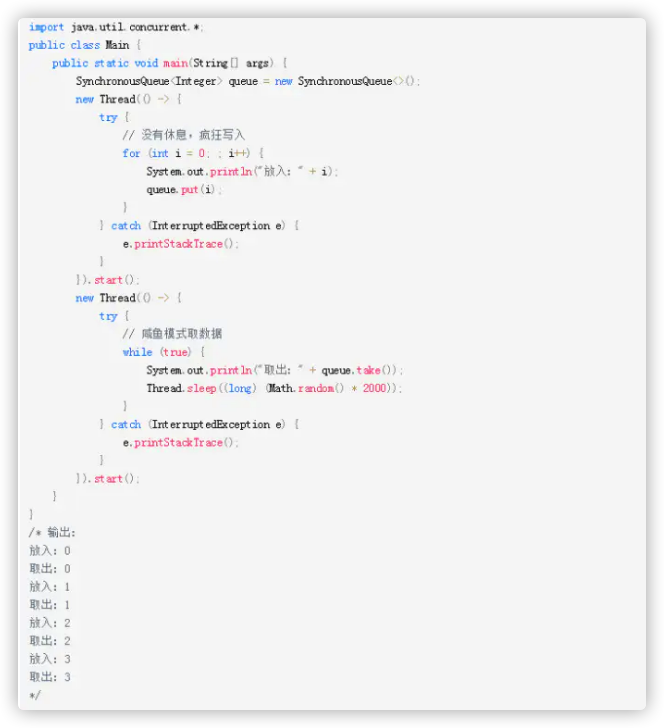

12.SynchronousQueue 数据同步交换的队列

一个虚假的队列,因为它实际上没有真正用于存储元素的空间,每个插入操作都必须有对应的取出操作,没取出时无法继续放入。

可以看到,写入的线程没有任何sleep,可以说是全力往队列放东西,而读取的线程又很不积极,读一个又sleep一会。输出的结果却是读写操作成对出现。

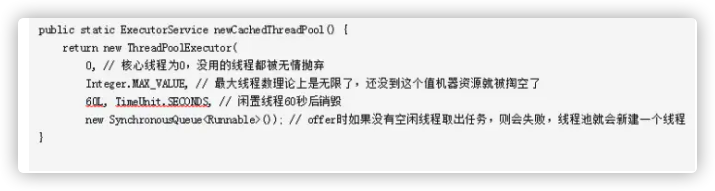

JAVA中一个使用场景就是Executors.newCachedThreadPool(),创建一个缓存线程池。

13.LinkedTransferQueue 基于链表的数据交换队列

实现了接口TransferQueue,通过transfer方法放入元素时,如果发现有线程在阻塞在取元素,会直接把这个元素给等待线程。如果没有人等着消费,那么会把这个元素放到队列尾部,并且此方法阻塞直到有人读取这个元素。和SynchronousQueue有点像,但比它更强大。

14.DelayQueue 延时队列

可以使放入队列的元素在指定的延时后才被消费者取出,元素需要实现Delayed接口。

总结

上面简单介绍了JAVA并发包下的一些容器类,知道有这些东西,遇到合适的场景时就能想起有个现成的东西可以用了。想要知其所以然,后续还得再深入探索一番。

十七、Future 和 CompletableFuture

CompletableFuture是java 8引入的,用于Java异步编程。异步编程是一种通过在与主应用程序线程不同的线程上运行任务并通知主线程其进度,完成或失败的方法来编写非阻塞代码的方法。 这样,您的主线程就不会阻塞/等待任务完成,并且可以并行执行其他任务。具有这种并行性可以大大提高程序的性能。

Future

Future被用作异步计算结果的参考。它提供了一个isDone()方法来检查计算是否完成,以及一个get()方法来检索计算完成后的结果。

Future VS CompletableFuture:

1.手动完成

Future提供了一个isDone()方法来检查计算是否完成,以及get()方法来检索计算结果。但是,Future不提供手动完成的方法。CompletableFuture的complete()方法可帮助我们手动完成Future

/**

* Manual Completion 手动完成

*/

private static void manualCompletion() throws ExecutionException, InterruptedException {

ExecutorService executorService = Executors.newSingleThreadExecutor();

CompletableFuture<String> future = CompletableFuture.supplyAsync(()->{

try {

Thread.sleep(2000);

} catch (InterruptedException e) {

e.printStackTrace();

}

return "1111";

});

executorService.submit(() -> {

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

//手动结束核心

future.complete("手动完成");

});

System.out.println(future.get());

executorService.shutdown();

}

因为Future的get()方法在完成计算的之前是阻塞的,我们可以使用complete()方法来手动完成计算。

2.多个Future组成调用链

/**

* 调用链

*/

public static void callbackChain() throws ExecutionException, InterruptedException {

CompletableFuture completableFuture

= CompletableFuture

.supplyAsync(() -> "Knolders!")

.thenRun(() -> System.out.println("Example with thenRun()."));

System.out.println(completableFuture.get());

}

3.组合多个CompletableFuture结果

如果是Future,则无法创建异步工作流程,即长时间运行的计算。但是CompletableFuture为我们提供了方法来实现此功能:

/**

* 组合

*/

private static void thenCompose() {

CompletableFuture<String> completableFuture =

CompletableFuture.supplyAsync(() -> "Hello")

.thenCompose(value ->

CompletableFuture.supplyAsync(

() -> value + " Knolders! Its thenCompose"));

completableFuture.thenAccept(System.out::println); // Hello Knolders! Its thenCompose

}

如果你希望合并要并行运行的100种不同的Future,然后在所有这些Future完成后再运行某些功能。可是使用如下方法:

/**

* 组合所有的结果

*/

private static void allOf() throws ExecutionException, InterruptedException {

CompletableFuture<String> completableFuture1

= CompletableFuture.supplyAsync(() -> "Hello");

CompletableFuture<String> completableFuture2

= CompletableFuture.supplyAsync(() -> "lv!");

CompletableFuture<String> completableFuture3

= CompletableFuture.supplyAsync(() -> "Its allOf");

/*

这个方法并不直接返回结果只是返回一个CompletableFuture

*/

CompletableFuture<Void> combinedFuture

= CompletableFuture.allOf(completableFuture1, completableFuture2, completableFuture3);

System.out.println(combinedFuture.get()); //输出null

assert (completableFuture1.isDone());

assert (completableFuture2.isDone());

assert (completableFuture3.isDone());

//使用以下两种方法获取最终结果

CompletableFuture<List<String>> listCompletableFuture = combinedFuture.thenApply(v ->

Stream.of(completableFuture1, completableFuture2, completableFuture3).

map(CompletableFuture::join).

collect(Collectors.toList()));

System.out.println(listCompletableFuture.get());

String combined = Stream.of(completableFuture1, completableFuture2, completableFuture3)

.map(CompletableFuture::join)

.collect(Collectors.joining(" "));

System.out.println(combined);

}

4.异常处理

如果发生异常,调用链将会停止调用。

private static void exception() {

Integer age = -1;

CompletableFuture<String> exceptionFuture = CompletableFuture.supplyAsync(() -> {

if (age < 0) {

throw new IllegalArgumentException("Age can not be negative");

}

if (age > 18) {

return "Adult";

} else {

return "Child";

}

}).exceptionally(ex -> {

System.out.println("Oops! We have an exception - " + ex.getMessage());

return "Unknown!";

});

exceptionFuture.thenAccept(System.out::println); //Unknown!

}

private static void exceptionUsingHandle() {

Integer age = -1;

CompletableFuture<String> exceptionFuture = CompletableFuture.supplyAsync(() -> {

if (age < 0) {

throw new IllegalArgumentException("Age can not be negative");

}

if (age > 18) {

return "Adult";

} else {

return "Child";

}

}).handle((result, ex) -> {

if (ex != null) {

System.out.println("Oops! We have an exception - " + ex.getMessage());

return "Unknown!";

}

return result;

});

exceptionFuture.thenAccept(System.out::println); // Unknown!

}

十八、……

JVM

对于 Java 程序员来说,JVM 帮助我们做了很多事情比如内存管理、垃圾回收等等。在 JVM 的帮助下,我们的程序出现内存泄漏这些问题的概率相对来说是比较低的。但是,这并不代表我们在日常开发工作中不会遇到。万一你在工作中遇到了 OOM 问题,你至少要知道如何去排查和解决问题吧! 并且,就单纯从面试角度来说,JVM 是 Java 后端面试(大厂)中非常重要的一环。不论是应届还是社招,面试国内的一些大厂,你都会被问到很多 JVM 相关的问题(应届的话侧重理论,社招实践)。

只有搞懂了 JVM 才有可能真正把 Java 语言“吃透”。学习 JVM 这部分的内容,一定要注意要实战和理论结合。

书籍的话,《深入理解 Java 虚拟机》 这本书是首先要推荐的。

下面是我总结的一些关于 JVM 的小问题,你可以拿来自测:

一、什么是虚拟机?

1、 什么是JVM?

JVM是Java Virtual Machine(Java虚拟机)的缩写,JVM是一种用于计算设备的规范,它是一个虚构出来的计算机,是通过在实际的计算机上仿真模拟各种计算机功能来实现的。Java虚拟机包括一套字节码指令集、一组寄存器、一个栈、一个垃圾回收堆和一个存储方法域。 JVM屏蔽了与具体操作系统平台相关的信息,使Java程序只需生成在Java虚拟机上运行的目标代码(字节码),就可以在多种平台上不加修改地运行。JVM在执行字节码时,实际上最终还是把字节码解释成具体平台上的机器指令执行。

Java语言的一个非常重要的特点就是与平台的无关性。而使用Java虚拟机是实现这一特点的关键。一般的高级语言如果要在不同的平台上运行,至少需要编译成不同的目标代码。而引入Java语言虚拟机后,Java语言在不同平台上运行时不需要重新编译。Java语言使用Java虚拟机屏蔽了与具体平台相关的信息,使得Java语言编译程序只需生成在Java虚拟机上运行的目标代码(字节码),就可以在多种平台上不加修改地运行。Java虚拟机在执行字节码时,把字节码解释成具体平台上的机器指令执行。这就是Java的能够“一次编译,到处运行”的原因。

2、JRE/JDK/JVM是什么关系?

JRE(JavaRuntimeEnvironment,Java运行环境),也就是Java平台。所有的Java 程序都要在JRE下才能运行。普通用户只需要运行已开发好的java程序,安装JRE即可。

JDK(Java Development Kit)是程序开发者用来来编译、调试java程序用的开发工具包。JDK的工具也是Java程序,也需要JRE才能运行。为了保持JDK的独立性和完整性,在JDK的安装过程中,JRE也是 安装的一部分。所以,在JDK的安装目录下有一个名为jre的目录,用于存放JRE文件。

JVM(JavaVirtualMachine,Java虚拟机)是JRE的一部分。它是一个虚构出来的计算机,是通过在实际的计算机上仿真模拟各种计算机功能来实现的。JVM有自己完善的硬件架构,如处理器、堆栈、寄存器等,还具有相应的指令系统。Java语言最重要的特点就是跨平台运行。使用JVM就是为了支持与操作系统无关,实现跨平台。

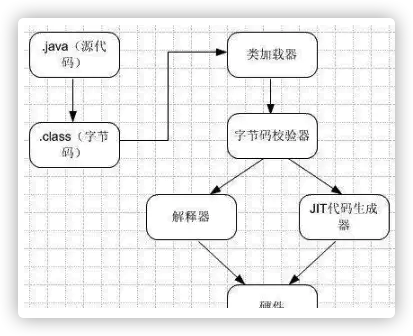

3、JVM原理

Java编译器只要面向JVM,生成JVM能理解的代码或字节码文件。Java源文件经编译成字节码程序,通过JVM将每一条指令翻译成不同平台机器码,通过特定平台运行。

我刚整理了一套2018最新的0基础入门和进阶教程,无私分享,加Java学习裙 :678-241-563 即可获取,内附:开发工具和安装包,以及系统学习路线图

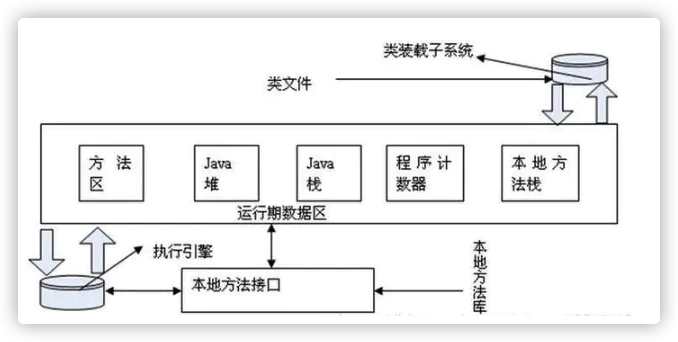

4、JVM的体系结构

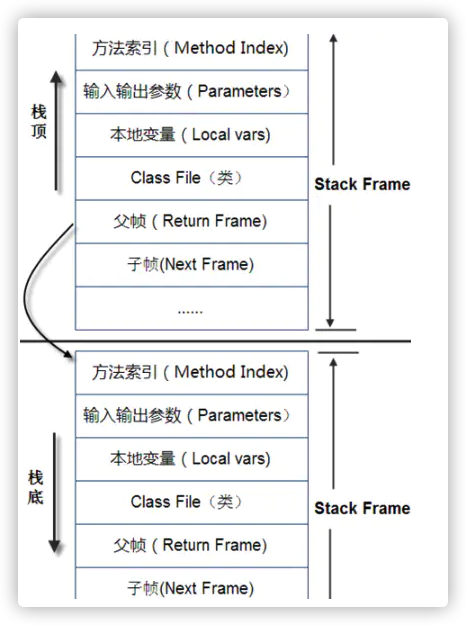

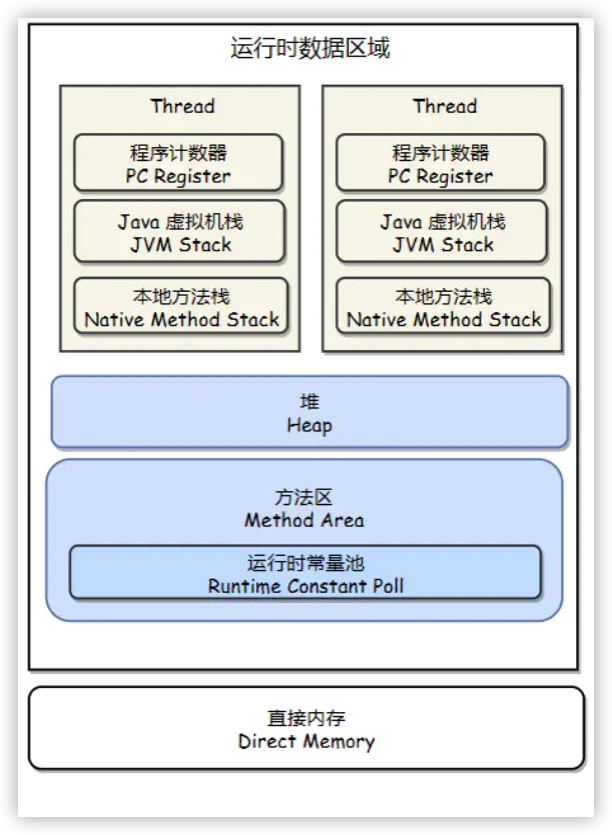

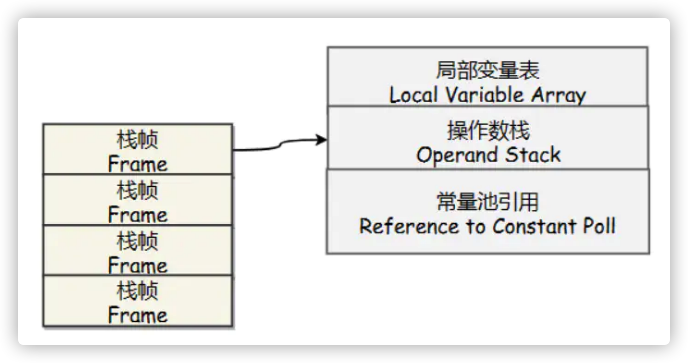

(1)java栈内存,它等价于C语言中的栈, 栈的内存地址是不连续的, 每个线程都拥有自己的栈。 栈里面存储着的是StackFrame,在《JVM Specification》中文版中被译作java虚拟机框架,也叫做栈帧。StackFrame包含三类信息:局部变量,执行环境,操作数栈。局部变量用来存储一个类的方法中所用到的局部变量。执行环境用于保存解析器对于java字节码进行解释过程中需要的信息,包括:上次调用的方法、局部变量指针和 操作数栈的栈顶和栈底指针。操作数栈用于存储运算所需要的操作数和结果。StackFrame在方法被调用时创建,在某个线程中,某个时间点上,只有一个 框架是活跃的,该框架被称为Current Frame,而框架中的方法被称为Current Method,其中定义的类为Current Class。局部变量和操作数栈上的操作总是引用当前框架。当Stack Frame中方法被执行完之后,或者调用别的StackFrame中的方法时,则当前栈变为另外一个StackFrame。Stack的大小是由两种类 型,固定和动态的,动态类型的栈可以按照线程的需要分配。 下面两张图是关于栈之间关系以及栈和非堆内存的关系基本描述:

(2) Java堆是用来存放对象信息的,和Stack不同,Stack代表着一种运行时的状态。换句话说,栈是运行时单位,解决程序该如何执行的问题,而堆是存储的单位, 解决数据存储的问题。Heap是伴随着JVM的启动而创建,负责存储所有对象实例和数组的。堆的存储空间和栈一样是不需要连续的。

(3)程序计数寄存器,程序计数器(Program Counter Register)是一块较小的内存空间,它的作用可以看做是当前线程所执行的字节码的行号指示器。在虚拟机的概念模型里(仅是概念模型,各种虚拟机可能会通过一些更高效的方式去实现),字节码解释器工作时就是通过改变这个计数器的值来选取下一条需要执行的字节码指令,分支、循环、跳转、异常处理、线程恢复等基础功能都需要依赖这个计数器来完成。

由于Java 虚拟机的多线程是通过线程轮流切换并分配处理器执行时间的方式来实现的,在任何一个确定的时刻,一个处理器(对于多核处理器来说是一个内核)只会执行一条线程中的指令。因此,为了线程切换后能恢复到正确的执行位置,每条线程都需要有一个独立的程序计数器,各条线程之间的计数器互不影响,独立存储,我们称这类内存区域为“线程私有”的内存。如果线程正在执行的是一个Java 方法,这个计数器记录的是正在执行的虚拟机字节码指令的地址;如果正在执行的是Natvie 方法,这个计数器值则为空(Undefined)。此内存区域是唯一一个在Java 虚拟机规范中没有规定任何OutOfMemoryError 情况的区域。

(4)方法区域(Method Area),在Sun JDK中这块区域对应的为PermanetGeneration,又称为持久代。方法区域存放了所加载的类的信息(名称、修饰符等)、类中的静态变量、类中定义为final类型的常量、类中的Field信息、类中的方法信息,当开发人员在程序中通过Class对象中的getName、isInterface等方法来获取信息时,这些数据都来源于方法区域,同时方法区域也是全局共享的,在一定的条件下它也会被GC,当方法区域需要使用的内存超过其允许的大小时,会抛出OutOfMemory的错误信息。

(5)运行时常量池(Runtime Constant Pool),存放的为类中的固定的常量信息、方法和Field的引用信息等,其空间从方法区域中分配。

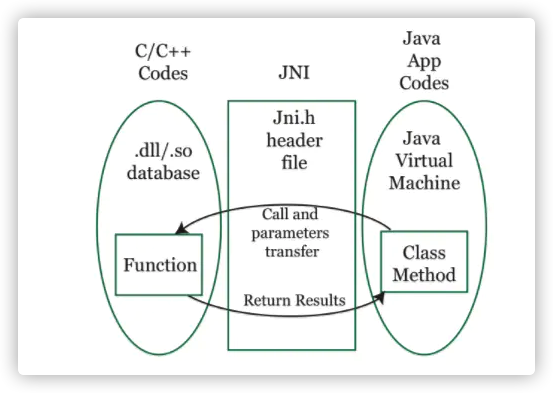

(6)本地方法堆栈(Native Method Stacks),JVM采用本地方法堆栈来支持native方法的执行,此区域用于存储每个native方法调用的状态。

二、Java 内存区域是怎么划分的?大对象放在哪个内存区域?

一、运行时数据区域

程序计数器

记录正在执行的虚拟机字节码指令地址(如果正在执行的是本地的方法则为空)。

虚拟机栈

每个Java方法在执行的同时会创建一个栈帧用于存储局部变量表、操作数栈、常量池引用等信息。每一个方法从调用直至执行完成的过程,就对应着一个栈帧在Java虚拟机栈中入栈和出栈的过程。

可以通过-Xss这个虚拟机参数来指定一个Java虚拟机栈内存大小:

java -Xss = 512M HackTheJava

该区域可能抛出以下异常: 1、当线程请求的栈深度超过最大值,会抛出StackOverflowError异常; 2、栈进行动态扩展时如果无法申请到足够内存,会抛出OutOfMemoryError异常。

本地方法栈

本地方法不是用Java实现,对待这些方法需要特别处理。 与Java虚拟机栈类似,它们之间的区别只不过是本地方法栈为本地方法服务。

堆

所有对象实例都在这里分配内存。

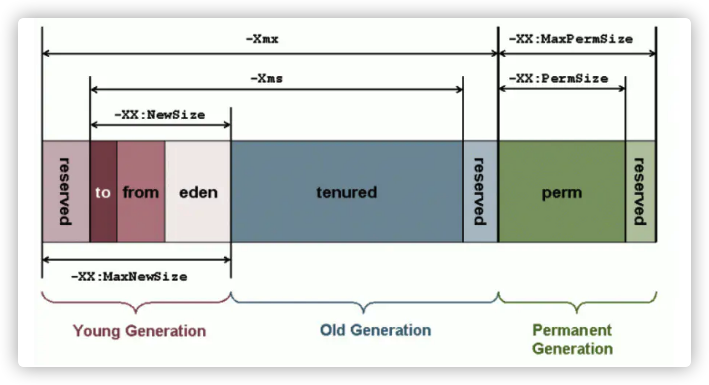

是垃圾收集器的主要区域(“GC堆”),现代的垃圾收集器基本都是采用分代收集算法,该算法的思想是针对不同的对象采取不同的垃圾回收算法,因此虚拟机把Java堆分成以下三块:

- 新生代(Young Generation)

- 老年代(Tenured Generation)

- 永久代(Permanent Generation)

当一个对象被创建时,首先进入新生代,之后有可能被转移到老年代中。新生代存放着大量的生命很短的对象,因此新生代在三个区域中垃圾回收的频率最高。为了更高效率地进行垃圾回收,把新生代分成以下三个空间:

- Eden

- From Survivor

- To Survivor

Java堆不需要连续内存,并且可以动态增加其内存,增加失败会抛出OutOfMenmoryError异常。 可以通过-Xms和-Xmx两个虚拟机参数来指定一个程序的Java堆内存大小,第一个参数设置初始值,第二个参数设置最大值。

java -Xms = 1M -Xmx = 2M HackTheJava

方法区

用于存放已被加载的类信息、常量、静态变量、即时编译器编译后的代码等数据。 和Java堆不一样不需要连续的内存,并且可以动态扩展,动态扩展失败一样会抛出OutOfMemoryError异常。 对这块区域进行垃圾回收的主要目标是对常量池的回收和类的卸载,但是一般比较难实现,HotSpot把它当成永久代来进行垃圾回收。

运行常量池

运行常量池是方法区的一部分。 Class文件中的常量池(编译器生成的各种字面量和符号引用)会在类加载后被放入这个区域。 除了在编译期生成的常量,还允许动态生成,例如String类的intern()。这部分常量也会被放入运行时常量池。

直接内存

在 JDK 1.4 中新加入了 NIO 类,它可以使用Native函数库直接分配堆外内存,然后通过一个存储在 Java 堆里的 DirectByteBuffer 对象作为这块内存的引用进行操作。这样能在一些场景中显著提高性能,因为避免了在 Java 堆和 Native 堆中来回复制数据。

二、垃圾收集

重拾Markdown,一些用法的使用记录

1、空行

起作用的:正文内容。 不起作用的:各级标题、分隔线、代码框编辑前后。使用前后都添加空行

2、缩进控制

缩进一个空格。

缩进两个空格。

https://www.jianshu.com/p/9d94660a96f1

3、代码展示

```和`两者包含的代码框有什么不同?

```代码框。

`代码片。

https://www.jianshu.com/p/b9b582bb6760

4、Markdown是否有转义字符的使用?

比如代码框符号```,引用符号>等。这个转义字符就是反斜杠 \。 https://www.jianshu.com/p/b9b582bb6760

5、简数编辑区域的Markdown怎么设置图片的位置?

暂时没有解决。

6、一些说明:

**图片连接地址前后都设置一个空行。**简书的markdown文章中的图片不用做其他设置都是默认居中,而在个人博客中却默认左对齐,具体效果如下图。对于有轻微强迫症的笔者决定将所有图片修改为居中对齐,搜索了一下,只需在markdown文件中的图片引用前后加上 HTML

-----空行----

<div align=center>

![]()

</div>

-----空行----

http://www.php-master.com/post/68996.html

7、强制换行

markdown编辑器下直接回车,预览时换行是显示不了的。这时就需要强制换行了。

强制换行语法:<br>。可以直接使用,在简书编辑区域同样有效。

8、杂

<br>与<br/>?

不同的标准下的产物,使用上没什么差异,相互兼容。

分隔符还是统一使用***;使用—如果它的上面没有空行,文字将会被误解析成标题。

Markdown编辑的文本在不同的解析器下面,换行的长度会不同。

三、垃圾回收有哪些算法?GC 的流程

导读

1、一个对象一生经历了什么? 2、如何判断对象是否可用? 3、引用计数法和可达性分析算法各自优缺点? 4、哪些对象可以作为GC ROOT? 5、垃圾回收的时候如何快速寻找根节点? 6、垃圾回收算法有哪些?各自优缺点? 7、有哪些垃圾回收器?各自优缺点?适用什么场景?

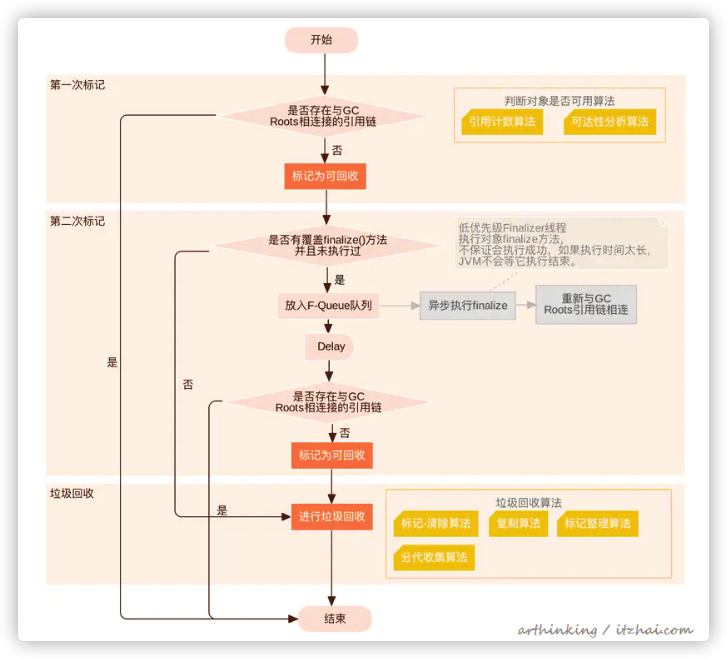

1、对象回收处理过程

2、判断用户是否可用计算

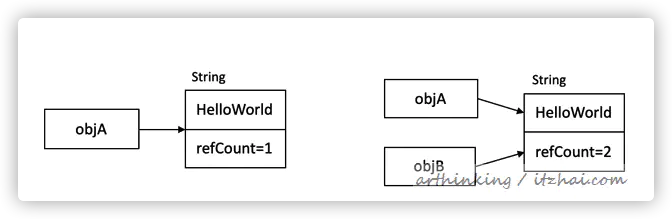

2.1、引用计数算法

如上图,给对象一个引用技术refCount。每有一个对象引用它,计时器加1,当它为0时,表示对象补课在用。

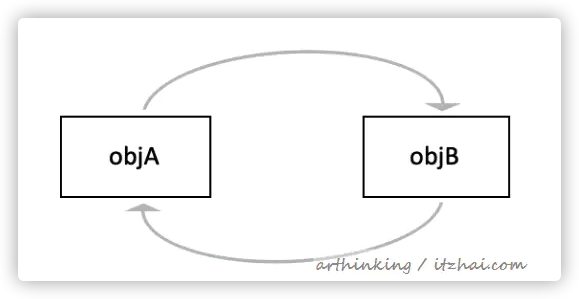

缺点。

很难解决循环引用的问题。

objA.instance = objB

objB.instance = objA

如上,即使objA和objB 都不在被访问后,但是它们还在 相互引用,所以计数器不会为0

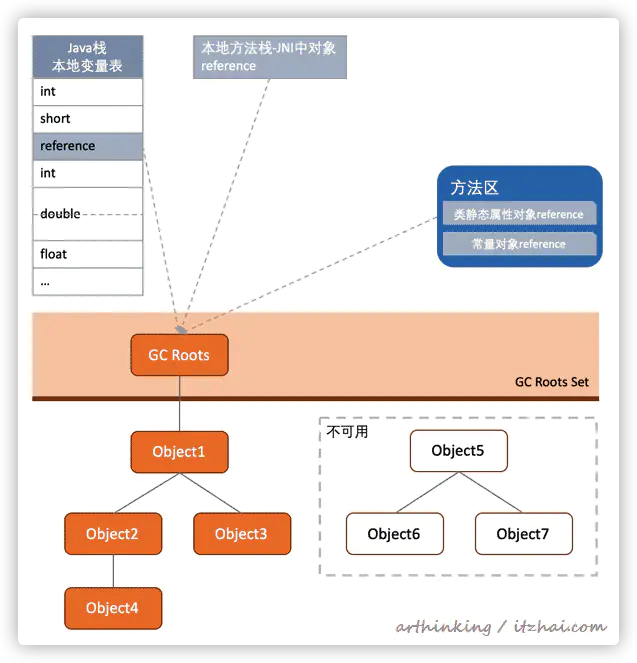

2.2、可达性分析算法

如上图,从GC Roots开始向下搜索,连接的路径为引用链;

GC Roots不可达的对象被判为不可用; 可作为GC Root的对象

如上图,虚拟机栈帧中本地变量表引用的对象,本地方法栈中,JNI引用的对象,方法区中的类静态属性引入的对象和常量引用对象都可以作为GC Root。

引用类型

- 强引用: 类似 object a = new object();

- 软引用:

SoftReference

ref = new SoftReference (“Hello World”);OOM前,JVM会把这些对象列入回收范围进行二次回收,如果回收后内存还是不做,则OOM。 - 弱引用:

WeakReference

weakCar = new WeakReference (car);每次垃圾收集,弱引用的对象就会被清理 - 虚引用: 幽灵引用,不能用来获取一个对象的实例,唯一用途:当一个虚引用引用的对象被回收,系统会收到这个对象被回收的通知。

3、HotSpot中如何实现判断是否存在与GC Roots相连接的引用链

第一小节流程图里的是否存在与GC Roots相连接的引用链 这个判断子流程是怎么实现的呢,这节我们来仔细探讨下。

一般的,我们都是选取可达性分析算法,这里主要阐述怎么寻找GC Root以及如何检查引用链。

3.1、枚举根节点

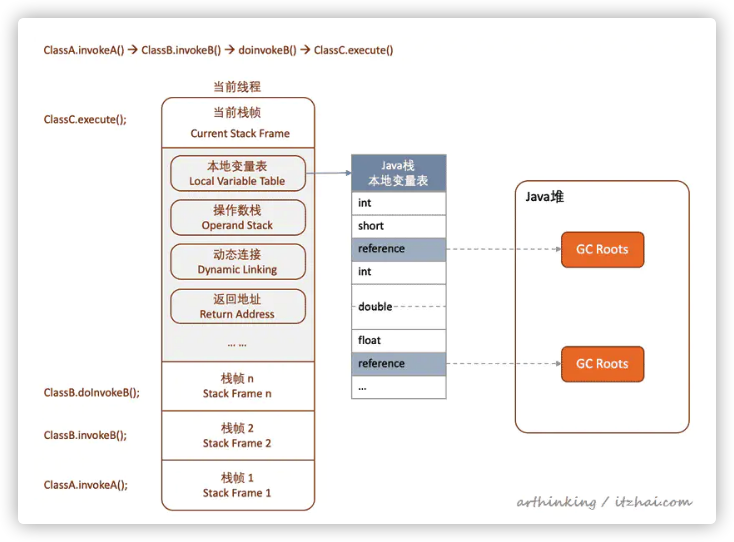

如上图,在一个调用关系为:

ClassA.invokeA() –> ClassB.invokeB() –>doinvokeB() –>ClassC.execute()

的情况下,每个调用对应一个栈帧,栈帧里面的本地变量表存储了GC Roots的引用。

如果直接遍历所有的栈去查找GC Roots,效率太低了。为此我们引入了OopMap和安全点的概念。

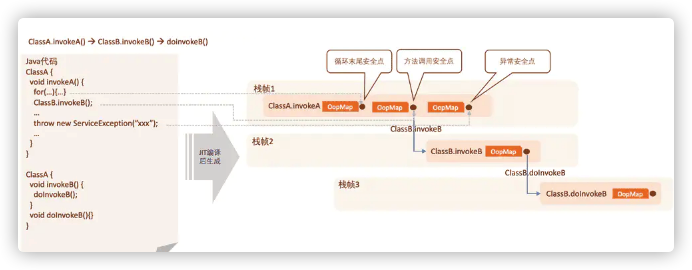

安全点和OopMap

如上图,在源代码编译的时候,会在特定位置下记录安全点,一般为:

1、循环的末尾

2、方法返回前 或者调用方法的call指令后

3、可能抛出异常的位置

通过安全点把代码分成几段,每段代码一个OopMap。

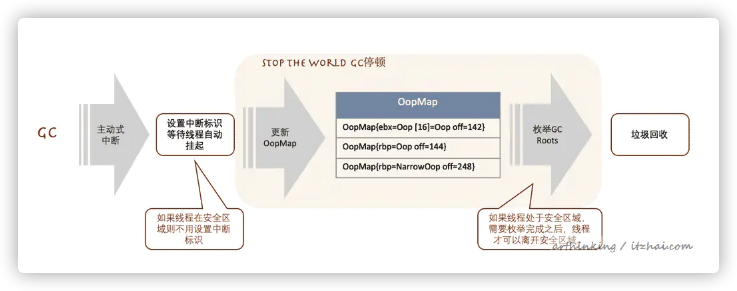

OopMap记录栈上本地变量到堆上对象的引用关系,每当触发GC的时候,程序都先跑的最近的安全点,然后自动挂起,然后在触发更新OopMap,然后进行枚举类GC ROOT,进行垃圾回收:

安全区域:在一段代码片段之中,引用关系不会发生变化,因此在这个区域中的任意位置开始 GC 都是安全的。如处于Sleep或者Blocked状态的线程。

为了在枚举GC Roots的过程中,对象的引用关系不会变更,所以需要一个GC停顿。

还有一种抢先式中断的方式,几乎没有虚拟机采用:先中断所有线程,发现线程没中断在安全点,恢复它,继续执行到安全点。

找到了该回收的对象,下一步就是清掉这些对象了,HotSpot将去交给CG收集器。

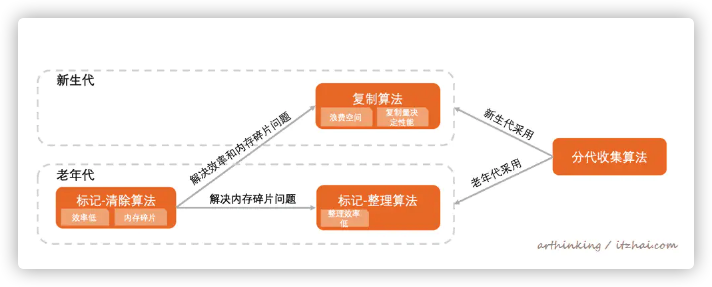

4、垃圾回收算法

概览图

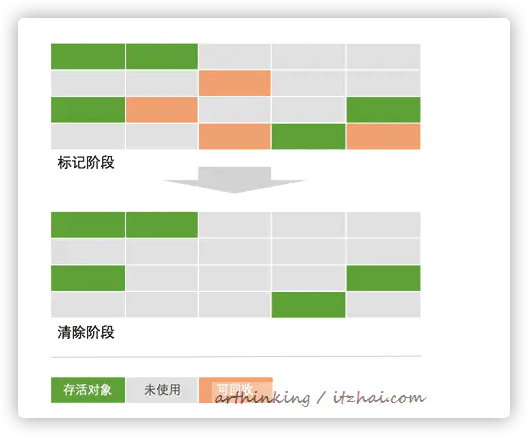

4.1、标记-清除算法

4.1.1、算法描述

标记阶段:标记处所有需要回收的对象;

清除阶段:标记成功后,统一回收所有被标记的对象;

4.1.2、不足

效率不高:标记和清除两个过程效率都不高;

空间问题:产生大量不连续的内存碎片,进而无法容纳大对象提早触发另一次GC.。

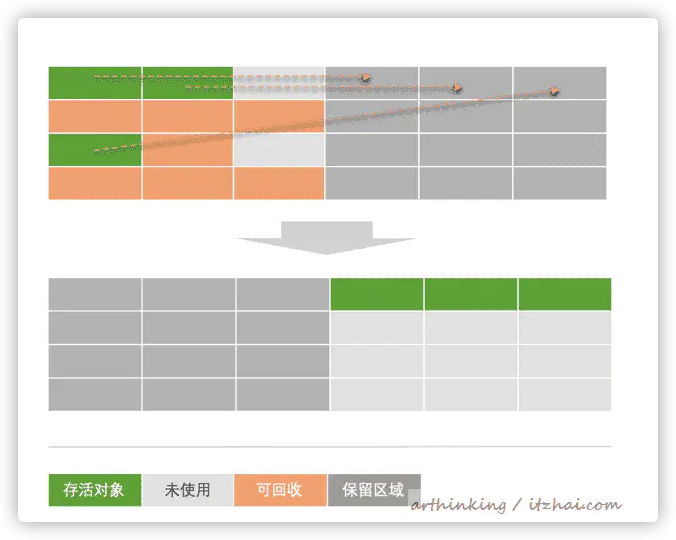

4.2、复制算法

4.2.1、算法描述

将可用内存分为容量大小相等的两块,每次只使用其中一块;

当一块用完,就将存活着的对象复制到另一块,然后将这块全部内存清理掉;

4.2.2、优点

不会产生不连续的内存碎片

提高效率:

回收:每次都是对整个半区进行回收;

分配:分配时也不用考虑内存碎片的问题,只要移动指针,按顺序分配内存即可。

4.2.3、缺点

可用内存缩小为原来的一半了,适合GC过后只有少量存活的新生代,可以根据实际情况,将内存块大小比例适当调整;

如果存活对象数量比较大,复制性能会变得很差。

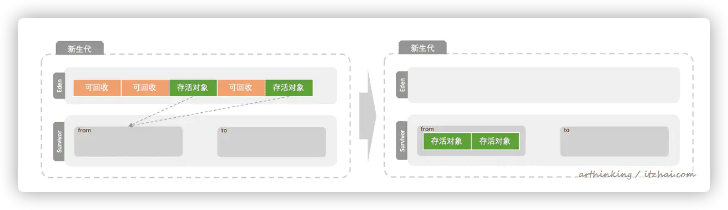

4.2.4、JVM中新生代的垃圾回收

如下图,分为新生代和老年代。其中新生代又分为一个Eden区和两个Survivor去(from区和to区),默认Eden : from : to 比例为8:1:1。

可通过JVM参数:-XX:SurvivorRatio配置比例,-XX:SurvivorRatio=8 表示 Eden区大小 / 1块Survivor区大小 = 8。

第一次Young GC

再次触发Young GC,扫描Eden区和from区,把存活的对象复制到To区,清空Eden区和from区。如果此时Survivor区的空间不够了,就会提前把对象放入老年代。

默认的,这样来回交换15次后,如果对象最终还是存活,就放入老年代。

交换次数可以通过JVM参数MaxTenuringThreshold进行设置。

4.2.5、JVM内存模型

JDK8之前

JDK8

如上图,JDK8的方法区实现变成了元空间,元空间在本地内存中。

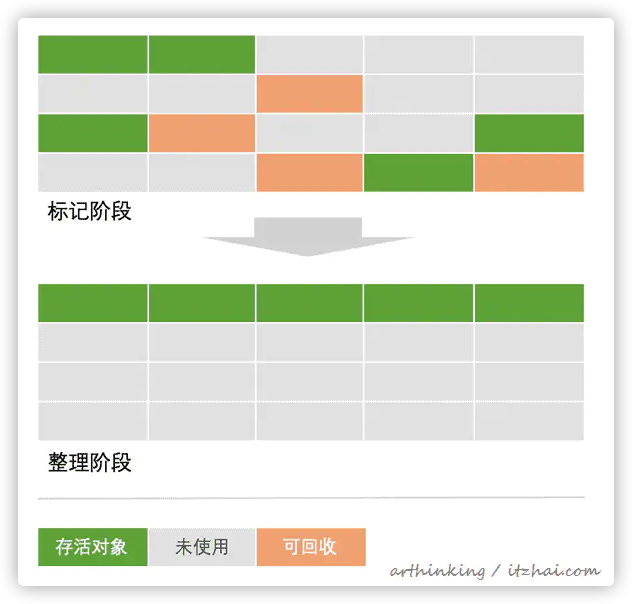

4.3、标记-整理算法

4.3.1、算法描述

标记过程与标记-清楚算法一样;

标记完成后,将存活对象向一端移动,然后直接清理掉边界以外的内存。

4.3.2、优点

不会产生内存碎片;

不需要浪费额外的空间进行分配担保;

4.3.3、不足

整理阶段存在效率问题,适合老年代这种垃圾回收频率不是很高的场景;

4.4、分代收集算法

当前商业虚拟机都采用该算法。

新生代:复制算法(CG后只有少量的对象存活)

老年代:标记-整理算法 或者 标记-清理算法(GC后对象存活率高)

5、垃圾回收器

这一步就是我们真正进行垃圾回收的过程了。

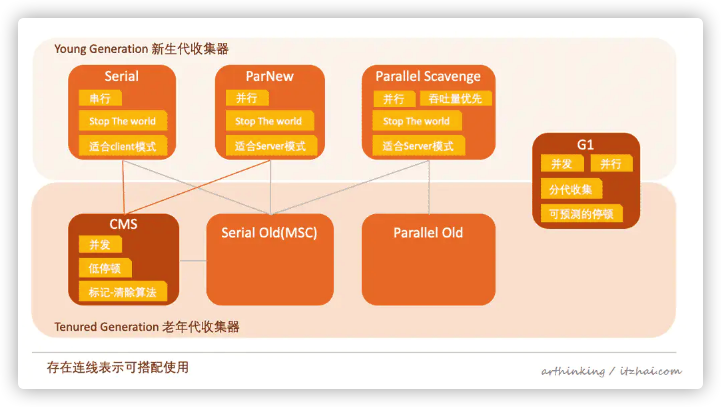

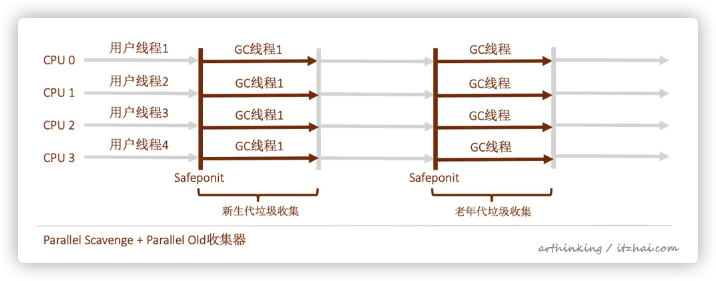

本节概念约定:并发:用户线程与垃圾收集线程同时执行,但不一定是并行,可能交替执行;并行:多条垃圾收集线程并行工作,单用户线程仍处于等待状态。

以下是垃圾收集器概览图

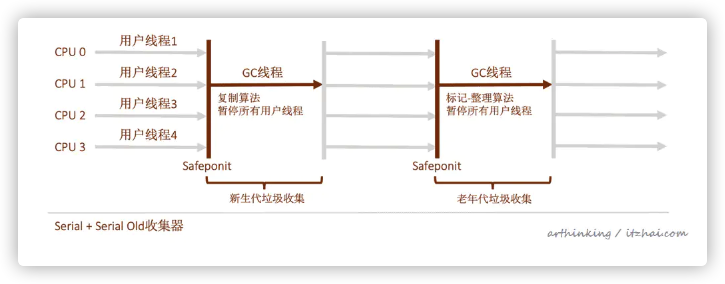

5.1、Serial收集器

5.1.1、特点

串行化:在垃圾回收时,必须赞同其他所有工作线程,知道收集结束,Stop The World;

在单CPU模式下无线程交互开销,专心做垃圾收集,简单高效。

5.1.2、适用场景

特别适合限定单CPU的环境;

Client模式下的默认新生代收集器,用户桌面应用场景分配给虚拟机的内存一般不会很大,所以停顿时间也是在一百多毫秒以内,影响不大。

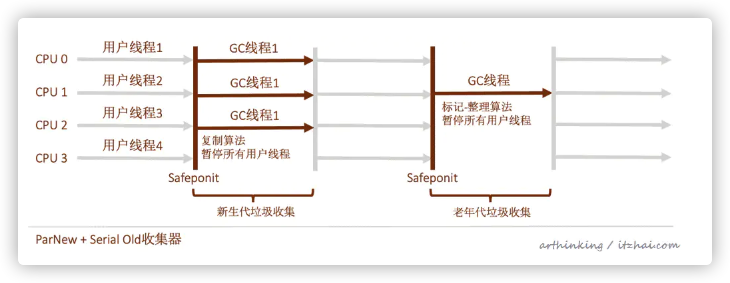

5.2、ParNew收集器

Parallel New?

5.2.1、特点

Serial收集器的多线程版本;

5.2.2、适用场景

许多运行在Server模式下的虚拟机中的首选新生代收集器;

除了Serial收集器外,只有它能和CMS收集器搭配使用。

-XX:+UseConcMarkSweepGC选型默认使用ParNew收集器。也可以使用-XX:+UseParNewGC选项强制指定它。

ParNew收集器在单CPU环境比Serial收集器效果差(存在线程交互开销)。

CPU数量越多,ParNew效果越好,默认开启收集线程数=CPU数量。可以使用-XX:ParallelGCThreads参数限制垃圾收集器的线程数。

5.3、Parallel Scavenge收集器

5.3.1、特点

新生代收集器,使用复制算法,并行多线程;

吞吐量优先收集器:CMS等收集器会关注如何缩短停顿时间,而这个收集器是为了吞吐量而设计的。

吞吐量 = 运行用户代码时间 / ( 运行用户代码时间 + 垃圾收集时间 )

也就是说整体垃圾收集时间越短,吞吐量越高。

5.3.2、适用场景

可以高效利用CPU时间,尽快完成程序的运算任务,适合后台运算不需要太多交互的任务;

5.3.3、相关参数

-XXMaxGCPauseMillis:设置最大垃圾收集停顿时间,大于0的毫秒数;

缩短GC停顿时间会牺牲吞吐量和新生代空间。新生代空间小,GC回收就快,但是同时会导致GC更加频繁,整体垃圾回收时间更长。

-XX:GCTimeRatio:设置吞吞量大小。0~100的整数,垃圾收集时间占总时间的比率,相当于吞吐量的倒数。

19: 1/(1+19)= 5%,即最大GC时间占比5%;

99: 1/(1+99)=1%,即最大GC时间占比1%;

-XX:+UseAdaptiveSizePolicy:GC自适应调节策略开关,打开开关,无需手工指定-Xmn(新生代大小)、-XX:SurvivorRatio(Eden与Survivor区比例)、-XX:PretenureSizeThreshold(晋升老年代对象年龄)等参数,虚拟机会收集性能监控信息,动态调整这些参数,确保提供最合适的 停顿时间或者最大吞吐量。

5.4、Serial Old收集器

5.4.1、特点

Serial收集器的老年代版本。使用单线程,标记-整理算法。

5.4.2、适用场景

主要给Client模式下的虚拟机使用;

Server模式下,量大用途:

JDK1.5版本之前的版本与Parallel Scavenge收集器搭配使用;

作为CMS收集器的后备预案,发生Concurrent Mode Failure时使用。

5.5、Parallel Olde收集器

5.5.1、特点

Parallel Scavenge收集器的老年代版本,使用多线程,标记整理算法。

5.5.2、使用场景

主要配合Parallel Scavenge使用,提高吞吐量。在注重吞吐量以及CPU资源敏感的场合,都可以优先考虑这个组合。

JDK1.6之后提供,之前Parallel Scavenge只能与Serial Old配合使用,老年代Serial Old无法充分利用服务器多CPU处理器能力,拖累了实际的吞吐量,效果不如ParNew+CMS组合;

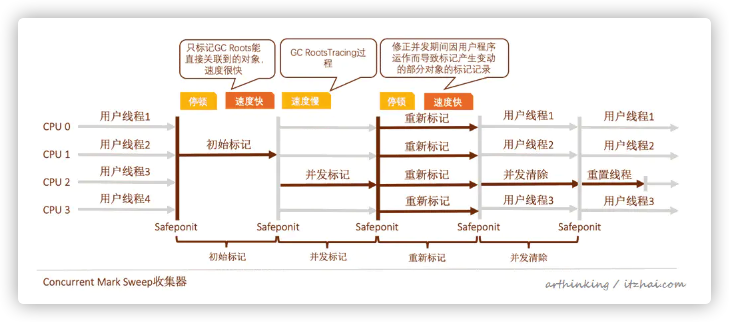

5.6、CMS收集器

Concurrent Mark Sweep

5.6.1、特点

设计目标:获得最短回收停顿时间;

注重服务响应速度;

标记-清除算法;

5.6.2、缺点

对CPU资源敏感,虽然不会导致用户线程停顿,但是会占用一部分线程(CPU资源)而导致应用程序变慢,吞吐量降低;

CMS收集器无法处理浮动垃圾。在CMS并发清理阶段,用户线程会产生垃圾。如果出现Concurrent Mode Failure失败,会启动后备预案:临时启动Serial Old收集器重新进行老年代垃圾收集,停顿时间更长了。-XX:CM SInitiatingOccupancyFraction设置的太高容易导致这个问题;

基于标记-清除算法,会产生大量空间碎片。

5.6.3、使用场景

互联网网站或者B/S系统的服务器;

5.6.4、相关参数

-XX:+UseCMSCompactAtFullCollection:在CMS要进行Full GC时进行内存碎片整理(默认开启)。内存整理过程无法并发,会增加停顿时间;

-XX:CMSFullGCsBeforeCompaction:在多少次 Full GC 后进行一次空间整理(默认0,即每一次 Full GC 后都进行一次空间整理);

-XX:CM SInitiatingOccupancyFraction:触发GC的内存百分比,设置的太高容易导致Concurrent Mode Failure失败(GC过程中,用户线程新增的浮动垃圾,导致触发另一个Full GC)。

CMS为什么要采用标记-清除算法?

CMS主要关注低延迟,所以采用并发方式清理垃圾,此时程序还在运行,如果采用压缩算法,则会涉及到移动应用程序的存活对象,这种场景下不做停顿是很难处理的,一般需要停顿下来移动存活对象,再让应用程序继续运行,但是这样停顿时间就边长了,延迟变长。CMS是容忍了空间碎片来换取回收的低延迟。

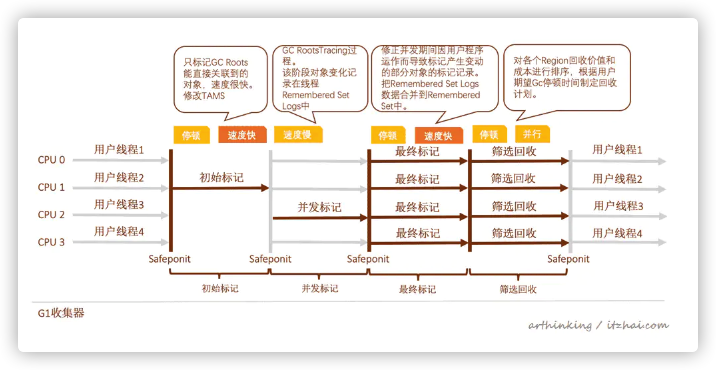

5.7、G1收集器

G1:Garbage-First,即优先回收价值最大的Region(注1)。

注1:G1与收集器将整个Java堆换分为多个代销相等的独立区域,跟踪各个Region里面的垃圾堆积的价值大小,优先回收价值最大的Region。

如上图,G1收集器分为四个阶段:

初始标记:只标记GC Roots能直接关联到的对象,速度很快。并修改TAMS(Next Top at Mark Start)的值,让下一阶段用户程序并发运行时,能够在正确可用的Region中创建新对象,这阶段需要停顿线程;

并发标记:GC RootsTracing过程。该阶段对象变化记录在线程Remembered Set Logs中。

最终标记:修正并发期间因用户程序运作而导致标记产生变动的部分对象的标记记录。把Remembered Set Logs数据合并到Remembered Set中。这个阶段需要停顿,但是可并行执行;

筛选回收:对各个Region回收价值和成本进行排序,根据用户期望Gc停顿时间制定回收计划。与CMS不一样,这里不用和用户线程并发执行,提高收集效率,使用标记-整理算法,不产生空间碎片。

5.7.1、特点

并行与并发:并发标记,并行最终标记与筛选回收;

分代收集

空间整合:基于标记-整理算法,不会产生碎片。

可预测的停顿:G与收集器将整个Java堆换分为多个代销相等的独立区域,避免在整个Java堆中进行全区域的垃圾回收,跟踪各个Region里面垃圾堆积的价值大小,后台维护一个优先列表,每次根据运行的收集时间,优先回收价值最大的Region。

四、什么是类加载?何时类加载?类加载流程?

类的加载过程介绍

介绍

类的加载指的是将类的 .class 文件中的二进制数据读入到 JVM 内存中,将其放在运行时数据区的 方法区 内,然后在 堆区 创建一个 java.lang.Class 对象,用来封装类在方法区内的数据结构。类的加载的最终是位于堆区中的 Class 对象,Class 对象封装了类在方法区内的数据结构,并且提供了访问方法区内的数据结构的接口。

类的加载过程分为 3 个步骤:加载;连接(验证、准备、解析);初始化,一般情况下 JVM 会连续完成 3 个步骤,有时也会只完成前两步。

如图

类加载过程.jpg

类加载器介绍

- 类加载介绍

- 系统可能在第一次使用某一个类时,加载该类,但也可能采用 预先加载机制 来加载该类,不管怎样类的加载必须由 类加载器 来完成。通常类加载器是由 JVM 提供。

- 类的加载必须由类加载器完成,通常情况下类加载器由 JVM 提供,但也可以通过自定义。

- JVM 提供的类加载器被称之为 系统类加载器

- 开发者还可以通过继承 ClassLoader 接口来创建 自定义类加载器

- 通过不同的类加载器,可以从不同的 “来源” 加载类的 .class 文件(二进制文件)

- 从本地系统中直接读取 .class 文件,大部分的加载方式。

- 从 ZIP、JAR 等归档文件中加载 .class 文件,很常见。

- 从网络下载 .class 文件数据。

- 从专有数据库中读取 .class 文件

- 将 Java 的源文件数据,上传到服务器中,进行动态编译产生 .class 文件,并加以执行。

- 但是不管 .class 文件数据来源何处,加载的结果都是相同的

- 将字节码文件数据加载到 JVM 内存中,将其放在运行时数据区的 方法区 内,然后在 堆区 创建一个 java.lang.Class 对象,用来封装类在方法区内的数据结构。类的加载的最终是位于堆区中的 Class 对象,Class 对象封装了类在方法区内的数据结构,并且提供了访问方法区内的数据结构的接口。

加载

作用

- 通过一个类的全限定名来获取其定义的字节码(二进制字节流),将字节码文件加载到 JVM 内存中,此过程由类加载器完成(可控)

特点

- 加载阶段是可控性最强的阶段,既可以使用系统提供的类加载器来完成加载,也可以自定义自己的类加载器来完成加载。

连接

验证

- 校验 .class 文件是否合法,遵循 .class 文件格式 参考地址

准备

- 为类变量(

static修饰的变量)在 JVM 方法区中分配内存,并进行 默认初始化int默认初始化为0- 引用默认初始化为

null - 等等

- 静态常量(

static final) ,有所不同,直接在 JVM 方法去中 显示初始化

- 为类变量(

解析

- JVM 将常量池的符号引用。替换为直接(地址)引用

特点

- 此时在堆区中已经创建一个 java.lang.Class 对象,指向方法区中的数据

初始化

作用

- 主要是对类静态的类变量进行 显示初始化 参考地址

- init 对非静态变量解析初始化

- clinit 是 java.lang.class 类构造器对静态变量,静态代码块进行初始化

- 类构造器方法(clinit)由编译器收集类中所有类变量的 显示赋值和静态代码块中的语句合并产生

- 主要是对类静态的类变量进行 显示初始化 参考地址

特点

- 当初始化某个类时,如果其父类没有初始化,则先触发父类的初始化动作

- JVM 保证一个类的初始化,在多线中中正确加锁和同步

何时会或者不会触发类初始化动作呢?

介绍

- 上面已经介绍,类的加载过程分为 3 步,大部分 3 步按顺序完成,有时也会只完成前两步

如何区分会不会触发类的初始化

- 如表

会触发类的初始化 不会触发类的初始化 当虚拟机启动时,先初始化 main()方法所在的类引用静态常量不会触发此类的初始化 一次 new一个类的对象(在 JVM 中一个类的 Class 对象只有一个)当访问一个静态域时,只有真正声明该域的类才会被初始化(子类继承父类的静态变量,在子类使用该静态变量时,只有父类会初始化,子类不会初始化) 调用该类的静态变量( static final除外,因为其在连接时已经显示初始化完成)和静态方法通过数组定义类引用时,不会触发类初始化( A[] as = new A[2]A 是类,此时不会初始化 A类)当初始化某个类时,其父类没有被初始化时,则会先初始化其父类

- 如表

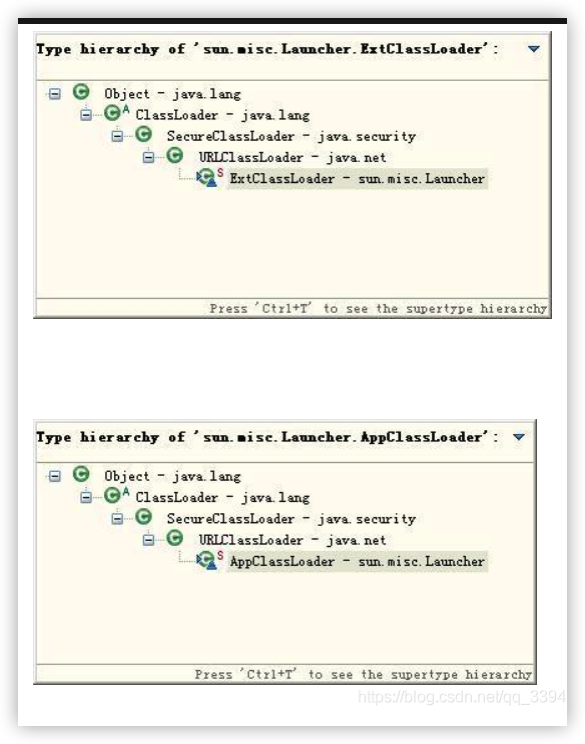

五、知道哪些类加载器。类加载器之间的关系?

一、三种类加载器

当 JVM 启动的时候,Java 缺省开始使用如下三种类型的类加载器:

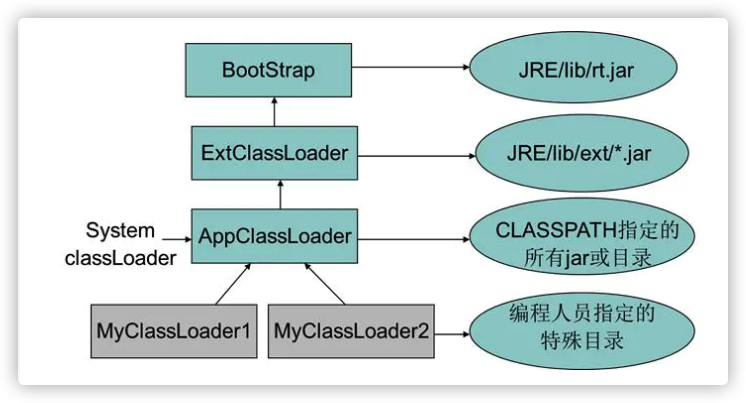

启动(Bootstrap)类加载器:引导类加载器是用 本地代码实现的类加载器,它负责将 <JAVA_HOME>/lib 下面的核心类库 或 -Xbootclasspath 选项指定的 jar 包等 虚拟机识别的类库 加载到内存中。由于引导类加载器涉及到虚拟机本地实现细节,开发者无法直接获取到启动类加载器的引用,所以 不允许直接通过引用进行操作。

扩展(Extension)类加载器:扩展类加载器是由 Sun 的 ExtClassLoader(sun.misc.Launcher$ExtClassLoader)实现的,它负责将 <JAVA_HOME>/lib/ext 或者由系统变量 - Djava.ext.dir 指定位置中的类库 加载到内存中。开发者可以直接使用标准扩展类加载器。

系统(System)类加载器:系统类加载器是由 Sun 的 AppClassLoader(sun.misc.Launcher$AppClassLoader)实现的,它负责将 用户类路径 (java -classpath 或 - Djava.class.path 变量所指的目录,即当前类所在路径及其引用的第三方类库的路径。开发者可以直接使用系统类加载器。

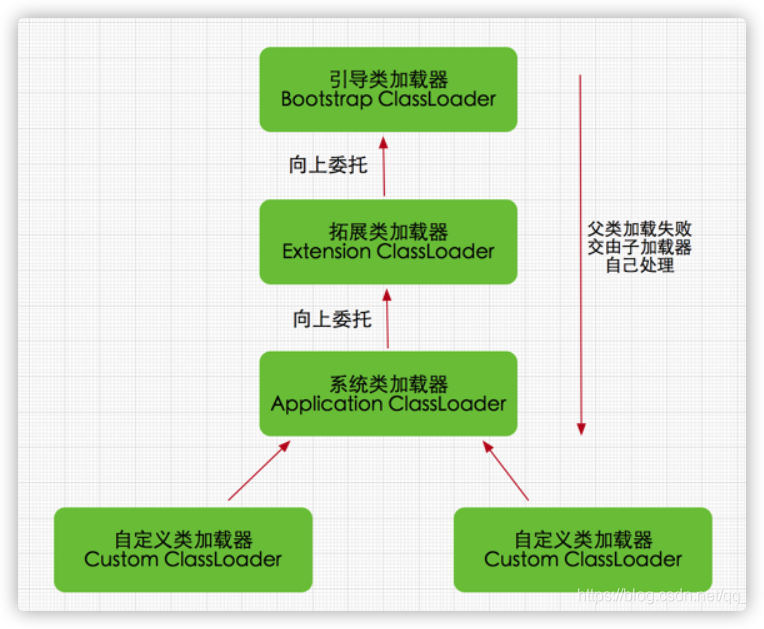

通过这两张图我们可以看出,扩展类加载器和系统类加载器均是继承自 java.lang.ClassLoader 抽象类。

二、类加载器的关系

关系如下:

上面图片给人的直观印象是:系统类加载器的父类加载器是标准扩展类加载器,标准扩展类加载器的父类加载器是启动类加载器。

事实上,由于启动类加载器无法被 Java 程序直接引用,因此 JVM 默认直接使用 null 代表启动类加载器。

此外:

1.系统类加载器(AppClassLoader)调用 ClassLoader (ClassLoader parent) 构造函数将父类加载器设置为标准扩展类加载器 (ExtClassLoader)。(因为如果不强制设置,默认会通过调用 getSystemClassLoader () 方法获取并设置成系统类加载器。)

2.扩展类加载器(ExtClassLoader)调用 ClassLoader (ClassLoader parent) 构造函数将父类加载器设置为 null(null 本身就代表着引导类加载器)。(因为如果不强制设置,默认会通过调用 getSystemClassLoader () 方法获取并设置成系统类加载器,。)

六、类加载器的双亲委派了解么? 结合 Tomcat 说一下双亲委派(Tomcat 如何打破双亲委托机制?…)。